La IA hace que los trabajadores sean más productivos, pero todavía nos faltan regulaciones, según una nueva investigación. El Informe del Índice de IA 2024, publicado por el instituto de Inteligencia Artificial Centrada en las Personas de la Universidad de Stanford, ha descubierto las ocho principales tendencias de IA para las empresas, incluido cómo la tecnología aún no supera al cerebro humano en todas las tareas. TechRepublic profundiza en las implicaciones comerciales de estas conclusiones, con la información de los coautores del informe Robi Rahman y Anka Reuel. VER: Las 5 principales tendencias de IA a tener en cuenta en 2024 1. Los humanos aún superan a la IA en muchas tareas Según la investigación, la IA todavía no es tan buena como los humanos en las tareas complejas de resolución de problemas matemáticos de nivel avanzado, razonamiento visual de sentido común y planificación ( Figura A). Para llegar a esta conclusión, se compararon los modelos con puntos de referencia humanos en muchas funciones empresariales diferentes, incluida la codificación, el comportamiento basado en agentes, el razonamiento y el aprendizaje por refuerzo. Figura A Rendimiento de los modelos de IA en diferentes tareas en relación con los humanos. Imagen: Informe del índice de IA 2024/HAI de la Universidad de Stanford. Si bien la IA superó las capacidades humanas en clasificación de imágenes, razonamiento visual y comprensión del inglés, el resultado muestra que existe potencial para que las empresas utilicen la IA para tareas en las que el personal humano realmente se desempeñaría mejor. Muchas empresas ya están preocupadas por las consecuencias de una dependencia excesiva de los productos de IA. 2. Los modelos de IA de última generación se están volviendo más caros El Índice de IA informa que entrenar GPT-4 de OpenAI y Gemini Ultra de Google costará aproximadamente 78 millones de dólares y 191 millones de dólares en 2023, respectivamente (Figura B). El científico de datos Rahman dijo a TechRepublic en un correo electrónico: «Con las tasas de crecimiento actuales, los modelos de IA de vanguardia costarán entre 5.000 y 10.000 millones de dólares en 2026, momento en el que muy pocas empresas podrán permitirse estos ciclos de formación». Figura B Costos de capacitación de los modelos de IA, 2017 a 2023. Imagen: AI Index Report 2024/Stanford University HAI/Epoch, 2023 En octubre de 2023, el Wall Street Journal publicó que Google, Microsoft y otros grandes actores tecnológicos estaban luchando por monetizar su capacidad generativa. Productos de IA debido a los enormes costos asociados con su funcionamiento. Existe el riesgo de que, si las mejores tecnologías se vuelven tan caras que sólo son accesibles para las grandes corporaciones, su ventaja sobre las PYMES podría aumentar desproporcionadamente. Esto fue señalado por el Foro Económico Mundial en 2018. Sin embargo, Rahman destacó que muchos de los mejores modelos de IA son de código abierto y, por lo tanto, están disponibles para empresas de todos los presupuestos, por lo que la tecnología no debería ampliar ninguna brecha. Le dijo a TechRepublic: “Los modelos de IA de código abierto y cerrado están creciendo al mismo ritmo. Una de las empresas de tecnología más grandes, Meta, está utilizando código abierto para todos sus modelos, por lo que las personas que no pueden darse el lujo de entrenar ellos mismos los modelos más grandes pueden simplemente descargar los suyos”. 3. La IA aumenta la productividad y la calidad del trabajo Al evaluar una serie de estudios existentes, los investigadores de Stanford concluyeron que la IA permite a los trabajadores completar tareas más rápidamente y mejora la calidad de su producción. Las profesiones en las que esto se observó incluyen programadores informáticos, donde el 32,8% informó un aumento de productividad, consultores, agentes de soporte (Figura C) y reclutadores. Figura C Impacto de la IA en la productividad de los agentes de atención al cliente. Imagen: AI Index Report 2024/Stanford University HAI/Brynjolfsson et al., 2023 En el caso de los consultores, el uso de GPT-4 cerró la brecha entre los profesionales poco calificados y los altamente calificados, y el grupo poco calificado experimentó más de un aumento del rendimiento (Figura D). Otras investigaciones también han indicado cómo la IA generativa en particular podría actuar como un igualador, ya que los trabajadores menos experimentados y menos calificados obtienen más provecho de ella. Figura D Mejora del desempeño laboral de consultores poco y altamente calificados cuando se utiliza IA. Imagen: Informe del índice de IA 2024/HAI de la Universidad de Stanford Sin embargo, otros estudios sugirieron que “el uso de IA sin la supervisión adecuada puede conducir a una disminución del rendimiento”, escribieron los investigadores. Por ejemplo, existen informes generalizados de que las alucinaciones prevalecen en modelos de lenguaje grandes que realizan tareas legales. Otras investigaciones han descubierto que es posible que no alcancemos todo el potencial de las ganancias de productividad impulsadas por la IA hasta dentro de una década, ya que los resultados insatisfactorios, las directrices complicadas y la falta de competencia siguen frenando a los trabajadores. 4. Las regulaciones de IA en los EE. UU. van en aumento El Informe del Índice de IA encontró que, en 2023, había 25 regulaciones relacionadas con la IA activas en los EE. UU., mientras que en 2016 solo había una (Figura E). Sin embargo, esta no ha sido una tendencia constante, ya que el número total de regulaciones relacionadas con la IA creció un 56,3% solo entre 2022 y 2023. Con el tiempo, estas regulaciones también han pasado de ser expansivas con respecto al progreso de la IA a restrictivas, y el tema más frecuente que abordan es el comercio exterior y las finanzas internacionales. Figura E Número de regulaciones relacionadas con la IA activas en los EE. UU. entre 2016 y 2023. Imagen: Informe del índice AI 2024/Universidad de Stanford HAI La legislación relacionada con la IA también está aumentando en la UE, con 46, 22 y 32 nuevas regulaciones aprobadas en 2021. , 2022 y 2023, respectivamente. En esta región, las regulaciones tienden a adoptar un enfoque más amplio y, en la mayoría de los casos, cubren la ciencia, la tecnología y las comunicaciones. VER: NIST establece un consorcio de seguridad de IA Es esencial que las empresas interesadas en la IA se mantengan actualizadas sobre las regulaciones que las afectan, o corren el riesgo de sufrir fuertes sanciones por incumplimiento y daños a su reputación. Una investigación publicada en marzo de 2024 encontró que solo el 2% de las grandes empresas del Reino Unido y la UE conocían la próxima Ley de IA de la UE. Más cobertura de IA de lectura obligada 5. La inversión en IA generativa está aumentando La financiación para productos de IA generativa que generan contenido en respuesta a un mensaje casi se octuplicó de 2022 a 2023, alcanzando los 25.200 millones de dólares (Figura F). OpenAI, Anthropic, Hugging Face e Inflection, entre otros, recibieron importantes rondas de recaudación de fondos. Figura F Inversión privada global total en IA generativa de 2019 a 2023. Imagen: AI Index Report 2024/Stanford University HAI/Quid, 2023 Es probable que el desarrollo de capacidades de IA generativa satisfaga la demanda de las empresas que buscan adoptarlas en sus procesos. En 2023, la IA generativa se citó en el 19,7 % de todas las llamadas sobre resultados de las empresas Fortune 500, y un informe de McKinsey reveló que el 55 % de las organizaciones utilizan ahora la IA, incluida la IA generativa, en al menos una unidad de negocio o función. El conocimiento de la IA generativa aumentó después del lanzamiento de ChatGPT el 30 de noviembre de 2022 y, desde entonces, las organizaciones han estado compitiendo para incorporar sus capacidades en sus productos o servicios. Una encuesta reciente de 300 empresas globales realizada por MIT Technology Review Insights, en asociación con Telstra International, encontró que los encuestados esperan que su número de funciones que implementan IA generativa se duplique en 2024. VER: Definición de IA generativa: cómo funciona, beneficios y Peligros Sin embargo, hay algunas pruebas de que el auge de la IA generativa “podría llegar a un final bastante rápido”, según Gary Marcus, destacado portavoz de la IA, y las empresas deberían tener cuidado. Esto se debe principalmente a las limitaciones de las tecnologías actuales, como la posibilidad de sesgos, problemas de derechos de autor e imprecisiones. Según el informe de Stanford, la cantidad finita de datos en línea disponibles para entrenar modelos podría exacerbar los problemas existentes, poniendo un límite a las mejoras y la escalabilidad. Afirma que las empresas de IA podrían quedarse sin datos lingüísticos de alta calidad para 2026, datos lingüísticos de baja calidad en dos décadas y datos de imágenes entre finales de la década de 2030 y mediados de la década de 2040. 6. Los puntos de referencia para la responsabilidad de LLM varían ampliamente Existe una variación significativa en los puntos de referencia con los que las empresas de tecnología evalúan sus LLM en lo que respecta a confiabilidad o responsabilidad, según el informe (Figura G). Los investigadores escribieron que esto «complica los esfuerzos para comparar sistemáticamente los riesgos y limitaciones de los mejores modelos de IA». Estos riesgos incluyen resultados sesgados y la filtración de información privada de conjuntos de datos de entrenamiento e historiales de conversaciones. Figura G Los puntos de referencia de IA responsable utilizados en el desarrollo de modelos de IA populares. Imagen: Informe del índice AI 2024/Universidad de Stanford HAI Reuel, estudiante de doctorado en el Laboratorio de Sistemas Inteligentes de Stanford, dijo a TechRepublic en un correo electrónico: “Actualmente no existen requisitos de informes, ni tenemos evaluaciones sólidas que nos permitan decir con confianza que un modelo es seguro si pasa esas evaluaciones en primer lugar”. Sin una estandarización en esta área, aumenta el riesgo de que algunos modelos de IA no confiables pasen desapercibidos y sean integrados por las empresas. «Los desarrolladores podrían informar selectivamente puntos de referencia que resalten positivamente el rendimiento de su modelo», añade el informe. Reuel dijo a TechRepublic: “Hay múltiples razones por las que un modelo dañino puede pasar desapercibido. En primer lugar, no hay evaluaciones estandarizadas o requeridas que dificulten la comparación de modelos y sus riesgos (relativos), y en segundo lugar, no hay evaluaciones sólidas, específicamente de los modelos básicos, que permitan una comprensión sólida y completa del riesgo absoluto de un modelo”. 7. Los empleados están nerviosos y preocupados por la IA. El informe también rastrea cómo las actitudes hacia la IA están cambiando a medida que aumenta la conciencia. Una encuesta encontró que el 52% expresa nerviosismo hacia los productos y servicios de IA, y que esta cifra había aumentado un 13% en 18 meses. También encontró que solo el 54% de los adultos está de acuerdo en que los productos y servicios que utilizan IA tienen más beneficios que inconvenientes, mientras que el 36% teme que pueda quitarles el trabajo en los próximos cinco años (Figura H). Figura H Opiniones globales sobre el impacto que la IA tendrá en los empleos actuales en 2023. Imagen: AI Index Report 2024/Stanford University HAI/Ipsos, 2023 Otras encuestas a las que se hace referencia en el AI Index Report encontraron que el 53 % de los estadounidenses actualmente se sienten más preocupados por la IA. que emocionados, y que la preocupación más común que comparten es su impacto en el empleo. Estas preocupaciones podrían tener un impacto particular en la salud mental de los empleados cuando las tecnologías de inteligencia artificial comiencen a integrarse en una organización, algo que los líderes empresariales deberían monitorear. VER: Los 10 mejores cursos de IA en 2024 8. EE. UU. y China están creando la mayoría de los LLM más populares de la actualidad. Ben Abbott de TechRepublic cubrió esta tendencia del informe de Stanford en su artículo sobre la construcción de modelos básicos de IA en la región APAC. Escribió, en parte: “El dominio de EE. UU. en IA continuó a lo largo de 2023. El informe del índice de IA de Stanford publicado en 2024 encontró que se habían lanzado 61 modelos notables en EE. UU. en 2023; esto estuvo por delante de los 15 nuevos modelos de China y de Francia, el mayor contribuyente de Europa con ocho modelos (Figura I). El Reino Unido y la Unión Europea como región produjeron 25 modelos notables, superando a China por primera vez desde 2019, mientras que Singapur, con tres modelos, fue el único otro productor de modelos lingüísticos grandes notables en APAC”. Figura I Estados Unidos está superando a China y otros países en el desarrollo de modelos de IA. Imagen: Época

Etiqueta: inteligencia artificial Página 1 de 16

El reciente auge de la inteligencia artificial (IA) ha traído consigo una nueva ola de dispositivos informáticos que cuentan con unidades de procesamiento neuronal (NPU) especializadas. Sin embargo, la necesidad de estas computadoras impulsadas por IA es un tema de debate. Osvaldo Doederlein, desarrollador de software de Google, sostiene que para muchos usuarios, estas máquinas representan un impulso tecnológico más que una respuesta a las necesidades genuinas de los usuarios. El auge de la informática impulsada por la IA: ¿exageración o necesidad? IA basada en la nube versus procesamiento local El núcleo del argumento de Doederlein radica en la prevalencia de la IA basada en la nube. Hoy en día, la gran mayoría de las aplicaciones de IA, desde el reconocimiento facial hasta el procesamiento del lenguaje natural (PNL), utilizan enormes granjas de servidores operadas por empresas como Google y Microsoft. Esta infraestructura en la nube ofrece una potencia de procesamiento incomparable, lo que permite modelos complejos de IA que no sería práctico ejecutar localmente en computadoras personales. NPU: poder para unos pocos Si bien el atractivo de ejecutar aplicaciones de IA localmente puede resultar atractivo, es crucial considerar el público objetivo. Los entusiastas y desarrolladores de la IA que trabajan con grandes modelos de lenguaje o herramientas de generación de imágenes podrían beneficiarse de la potencia de procesamiento de la IA local. Sin embargo, para el usuario medio, las ventajas son menos claras. La inclusión de NPU en chips de consumo a menudo implica una compensación. Estos chips pueden tener menos núcleos de CPU tradicionales o memoria caché reducida para adaptarse al hardware NPU especializado. Esto puede traducirse en una experiencia de menor rendimiento para las tareas cotidianas fuera del ámbito de aplicaciones específicas de IA. Preocupaciones por la seguridad y la privacidad Además, la etapa inicial de la tecnología NPU genera preocupaciones sobre la seguridad y la privacidad. Las CPU tradicionales se han sometido a años de rigurosas pruebas y mejoras de seguridad. Las arquitecturas NPU recientemente introducidas pueden tener vulnerabilidades imprevistas. Además, la dependencia de hardware especializado podría limitar la capacidad de implementar futuros parches de seguridad. Privacidad: una espada de doble filo Doederlein también destaca el atractivo limitado de una mayor privacidad que ofrece el procesamiento local de IA. Si bien la IA basada en la nube plantea preocupaciones sobre la privacidad en relación con la recopilación y el almacenamiento de datos, el interés de los usuarios en estos asuntos parece relativamente bajo. Además, ejecutar aplicaciones de IA localmente no garantiza una privacidad total. Las actualizaciones y correcciones de errores a menudo requieren interacción con servidores externos, lo que potencialmente expone los datos del usuario. El cuello de botella del hardware Más allá de las desventajas inmediatas, Doederlein enfatiza la posibilidad de que las limitaciones del hardware reduzcan aún más la necesidad de procesamiento local de IA. Incluso si la tecnología NPU madura, otros componentes de hardware como el ancho de banda de la memoria o la velocidad de almacenamiento podrían surgir como cuellos de botella, obstaculizando las ganancias generales de rendimiento. El futuro de la informática con IA El debate en torno a las computadoras impulsadas por IA no niega el potencial transformador de la IA en sí. Sin embargo, subraya la importancia de centrarse en las necesidades de los usuarios y no únicamente en impulsar nuevas tecnologías. El futuro ideal de la informática con IA probablemente resida en un enfoque equilibrado. La IA basada en la nube seguirá haciendo el trabajo pesado, mientras que los avances en el diseño de chips pueden mejorar aplicaciones específicas en los dispositivos de los usuarios. Esta sinergia garantizará que la tecnología de IA siga siendo accesible y beneficiosa para una gama más amplia de usuarios. Más allá de lo binario: oportunidades y consideraciones La conversación sobre la informática impulsada por IA se extiende más allá de un simple binario de necesario versus innecesario. Hay varios aspectos adicionales a considerar: Noticias de la semana de Gizchina Evolución de las aplicaciones de IA: a medida que la tecnología de IA madura, pueden surgir aplicaciones con menores demandas de procesamiento, lo que las hace adecuadas para la ejecución local en futuras generaciones de computadoras personales con NPU más avanzadas. El poder de la especialización: si bien es posible que la informática de propósito general no se beneficie enormemente de las NPU inicialmente, los dispositivos especializados como los centros domésticos inteligentes o los robots autónomos podrían experimentar mejoras significativas en el rendimiento con hardware de IA dedicado. El ecosistema de desarrolladores: un ecosistema de desarrolladores sólido es crucial para crear aplicaciones de IA atractivas que aprovechen las capacidades de los dispositivos equipados con NPU. Sin una masa crítica de desarrolladores, el potencial del procesamiento local de IA podría no aprovecharse. Veredicto El auge de la informática impulsada por la IA presenta tanto oportunidades como desafíos. Al reconocer las limitaciones actuales y centrarse en las necesidades de los usuarios, la industria puede garantizar que la tecnología de IA evolucione de una manera que realmente beneficie a los consumidores. Es probable que el futuro de la informática con IA sea colaborativo, aprovechando el poder de la infraestructura de la nube con avances en las capacidades de procesamiento local para crear una experiencia fluida y centrada en el usuario. El camino por delante: navegar por el panorama cambiante de la informática con IA Si bien el estado actual de la informática impulsada por la IA puede no ser universalmente necesario, la innovación continua promete dar forma a su trayectoria futura. Estas son algunas áreas clave a tener en cuenta: Relación simbiótica con la IA en la nube: La IA basada en la nube, sin duda, seguirá siendo una fuerza dominante. A medida que los modelos de IA se vuelven más complejos, la gran potencia de procesamiento de las granjas de servidores será vital para tareas como simulaciones científicas o reconocimiento de imágenes a gran escala. Sin embargo, el procesamiento de IA local puede complementar estas capacidades manejando tareas que requieren menos recursos o realizando un procesamiento preliminar antes de descargar datos a la nube. Este enfoque colaborativo puede optimizar las cargas de trabajo y mejorar la eficiencia general. Computación neuromórfica y biomímesis: las computadoras tradicionales luchan por imitar la eficiencia del cerebro humano en ciertas tareas. La computación neuromórfica tiene como objetivo cerrar esta brecha mediante el diseño de hardware inspirado en la estructura y función del sistema nervioso. Estos chips neuromórficos podrían ofrecer importantes ventajas de rendimiento para tipos específicos de aplicaciones de IA, lo que podría hacer que el procesamiento local sea más atractivo para tareas como el reconocimiento de patrones o la toma de decisiones en tiempo real. El auge de la computación de borde: la computación de borde se refiere al procesamiento de datos más cerca de su fuente, a menudo en dispositivos en la periferia de la red. Este enfoque puede resultar particularmente beneficioso para aplicaciones que requieren baja latencia, como vehículos autónomos o sistemas de control industrial. Los dispositivos de vanguardia impulsados por IA podrían realizar análisis y toma de decisiones en tiempo real, reduciendo la dependencia de los recursos centralizados de la nube. Consideraciones éticas y desarrollo responsable: a medida que la tecnología de IA se vuelve más sofisticada, las consideraciones éticas se vuelven primordiales. El desarrollo y la implementación de computadoras impulsadas por IA deben priorizar la transparencia, la equidad y la rendición de cuentas. Es posible que sean necesarias regulaciones para garantizar la recopilación responsable de datos, mitigar el sesgo en los algoritmos y salvaguardar la privacidad del usuario. La interfaz hombre-máquina: el futuro de la informática con IA depende de una interfaz perfecta hombre-máquina. Las interfaces fáciles de usar que permitan una interacción intuitiva con dispositivos impulsados por IA serán cruciales para una adopción generalizada. Además, fomentar la colaboración entre humanos y la IA en lugar de verlos como reemplazos será clave para maximizar los beneficios de esta tecnología. En conclusión, el campo de la informática impulsada por la IA está repleto de potencial. Al reconocer las limitaciones actuales, fomentar la colaboración entre la nube y el procesamiento local y priorizar el desarrollo responsable, la industria puede allanar el camino para un futuro en el que la tecnología de IA empodere a los usuarios y enriquezca nuestras vidas. El viaje que tenemos por delante promete ser de aprendizaje continuo, adaptación e innovación responsable.

Una investigación realizada en 2023 por la iniciativa Grandes modelos europeos de IA encontró que el 73% de los modelos básicos de IA desde 2017 eran de EE. UU. y el 15% de China. Advirtió que a Alemania le faltaba un “cambio de paradigma” de IA que podría “poner en peligro la soberanía digital de Europa”. El dominio del modelo de base de IA de EE. UU. y China está generando preocupaciones similares en los países de APAC. Existen algunos temores de que esto pueda afectar a los ciudadanos y empresas de la región en áreas que incluyen la seguridad y la gobernanza de los datos, así como el riesgo geopolítico o de la cadena de suministro. Estados-nación como Singapur, Japón y Australia están respondiendo desarrollando o considerando modelos de bases soberanas de IA. Por ejemplo, el organismo científico nacional de Australia, la Organización de Investigación Científica e Industrial de la Commonwealth, publicó recientemente un documento preguntando si Australia debería invertir en sus propios modelos de fundaciones. Las empresas podrían beneficiarse de modelos que sean más sensibles a los matices de su cultura o idioma y prometan mantener los datos seguros y conformes dentro de las fronteras de su propio país. La creación de modelos soberanos de IA también podría ayudar a desarrollar ecosistemas locales de computación y habilidades de IA. Descargue estos 10 casos de uso principales de inteligencia artificial de TechRepublic Premium El dominio de la IA de EE. UU. y China estimula el interés en la IA soberana El dominio de los EE. UU. en IA continuó durante 2023. El informe del índice de IA de Stanford publicado en 2024 encontró que se habían lanzado 61 modelos notables en los EE. UU. en 2023; esto estuvo por delante de los 15 nuevos modelos de China y de Francia, el mayor contribuyente de Europa con ocho modelos (Figura A). La Unión Europea en su conjunto produjo 21 modelos notables, mientras que Singapur, con tres modelos, fue el único otro productor de modelos lingüísticos grandes notables en APAC. Figura A Estados Unidos está superando a China y otros países en el desarrollo de modelos de IA. Imagen: Epoch EE. UU. y China están creando muchos de los LLM más populares de la actualidad. Muchos LLM utilizados ampliamente en APAC se originan en los EE. UU., incluidos ChatGPT 3.5 y GPT-4 de OpenAI, Llama de Meta, Google Gemini, Claude de Anthropic y Copilot de Microsoft, así como open- Modelos fuente como BERT. VER: Cómo ve el gobierno australiano que la IA acelera la productividad China es el mayor desafío para los EE. UU., y algunas empresas utilizan Llama 1 de código abierto para capacitar a nuevos LLM. Los modelos notables de China incluyen Ernie Bot estilo ChatGPT de Baidu, que ahora tiene 200 millones de usuarios, y un LLM desarrollado por Alibaba adaptado a los idiomas del sudeste asiático llamado SeaLLM. Los líderes de la industria centran el debate en las capacidades soberanas de la IA. Las partes interesadas clave de la industria están abogando por una IA más soberana. El director ejecutivo de NVIDIA, Jensen Huang, dijo durante una reciente Cumbre Mundial de Gobiernos que cada país necesitaba «ser dueño de la producción de su propia inteligencia», recomendando que «codifiquen su idioma, datos y cultura» en su propio LLM. Como informó Business Standard, el director ejecutivo de IBM, Arvind Krishna, dijo: «Todos los países deberían tener capacidad soberana en materia de inteligencia artificial, incluidos grandes modelos de lenguaje e IA generativa», para «utilizarla para fines en los que el resto del mundo no quiere invertir». en, o que tal vez no quiera exponer a otros «. Más cobertura de IA de lectura obligada La concentración del mercado de Foundation LLM tiene riesgos para las empresas Muchas empresas en APAC están personalizando los modelos de IA existentes y implementando medidas para proteger la propiedad intelectual de ser absorbida por modelos de capacitación en el extranjero. Sin embargo, la falta de modelos soberanos de IA y el dominio de algunos Estados-nación exponen a las empresas a riesgos. En el documento de CSIRO publicado en marzo de 2024, se señalaron factores clave que Australia debería sopesar al considerar si construir su propio modelo soberano de IA; Estos factores también se aplican a otros países de la región APAC. Mercados y precios competitivos: las empresas pueden terminar dependiendo de un pequeño número de proveedores de modelos de IA dominantes en mercados extraterritoriales, con el poder de fijar precios para cosas como el acceso a API. En abril de 2024, la Autoridad de Mercados y Competencia del Reino Unido señaló “preocupaciones reales” sobre una red interconectada ya existente de 90 asociaciones e inversiones estratégicas que involucran a las mismas empresas, a saber, Google, Apple, Microsoft, Meta, Amazon y NVIDIA. Fiabilidad y estabilidad: la dependencia de LLM de propiedad privada expone a las empresas a cambios inesperados. Dos ejemplos son el despido y reinstalación del director ejecutivo Sam Altman por parte de OpenAI o la adquisición de Twitter por parte de Elon Musk, que provocó que muchos usuarios institucionales cambiaran sus estrategias digitales. Relevancia y sensibilidad cultural: los países asiáticos están viendo la importancia de tener LLM construidos a partir de conjuntos de datos locales. Esto garantizaría que los resultados integren normas culturales y matices lingüísticos o brinden asesoramiento correcto sobre las leyes, requisitos y procesos locales. Confidencialidad, privacidad y seguridad de la información: todavía existen preocupaciones sobre la introducción de datos privados o sensibles en modelos de IA en el extranjero; esto está impidiendo que las instituciones del sector público adopten plenamente los LLM. Sin una protección adecuada de los datos, la propiedad intelectual de una organización podría estar en riesgo. Riesgos geopolíticos: siempre existe el riesgo de que un evento geopolítico importante pueda poner en riesgo a las organizaciones o agencias si dependen de modelos de IA extraterritoriales. El CSIRO añadió que es posible que se utilicen para influir en la opinión pública de otras naciones soberanas. Ética y moderación de contenidos: la ética puede ser importante para las organizaciones privadas que utilizan diferentes modelos. Por ejemplo, OpenAI es objeto de varias demandas por los datos de capacitación utilizados para construir sus modelos, lo que deja a las organizaciones potencialmente en riesgo si los usan. El riesgo soberano debe equilibrarse con las oportunidades para las empresas El CSIRO dijo que si bien la IA generativa representa importantes oportunidades para las empresas, “la dependencia de modelos básicos de IA fabricados y operados en el extranjero (o corporaciones tecnológicas privadas) también crea riesgos de capacidad soberana y preocupaciones sobre la equidad y mercados abiertos para el desarrollo de productos”, algo que los países y las empresas tratarían de evitar. Países de Asia y el Pacífico que trabajan en sus propios LLM personalizados. Los países de APAC están considerando la falta de capacidades soberanas de IA. Singapur, Japón y Australia ya están invitando a debatir o implementar políticas para comenzar el proceso de reequilibrio de la hegemonía de la IA que existe en el mercado mundial de modelos de bases. Singapur Singapur inició un programa de 51 millones de dólares (80 millones de dólares australianos), denominado Programa Nacional Multimodal LLM (NMLP), para desarrollar un modelo base con contexto regional que pueda comprender las características lingüísticas únicas y el entorno multilingüe. La Autoridad de Desarrollo de Medios de Infocomm dijo que se basaría en los primeros resultados del modelo SEA-LION (Lenguajes del Sudeste Asiático en una Red) de AI Singapur, un LLM de código abierto de menor escala que es más representativo del contexto cultural y los idiomas de la región. Cuando se entregó, la IMDA dijo que sería el LLM regional inaugural del sudeste asiático. Se espera que los modelos y casos de uso estén disponibles a partir del proyecto en los próximos dos años. Japón El Partido Liberal Democrático Japonés recomendó a principios de 2023 que la nación “construya y fortalezca capacidades de desarrollo de modelos de IA, incluidos los modelos básicos”, destacando el deseo de habilidades y experiencia, conjuntos de datos y recursos computacionales para un ecosistema de IA. El gobierno señaló una preocupación particular con los recursos informáticos. En septiembre de 2023, se reveló que Japón se está asociando con empresas como NEC, Fujitsu y SoftBank para desarrollar sus propios LLM como ChatGPT, que se adaptarían a las complejidades del idioma y la cultura japonesa. Australia El documento de CSIRO analizó una serie de medidas de mitigación que podrían respaldar una posición australiana fortalecida en el orden global de la IA. Estos incluyeron la construcción de la infraestructura informática necesaria asegurando chips aceleradores de IA de alto rendimiento, o GPU, en medio de una alta demanda global. El CSIRO también planteó la posibilidad de identificar, validar y poner a disposición conjuntos de datos para entrenar modelos básicos de IA y aumentar las habilidades de IA de la fuerza laboral a través de la capacitación, la educación y un mejor acceso a los grupos de talentos. VER: Cómo el CSIRO está impulsando la inversión en IA en Australia a través de la competencia Además, el CSIRO preguntó si Australia podría negociar colaboraciones internacionales bilaterales o multilaterales para compartir experiencia y recursos en IA o invertir en la construcción, el ajuste y la aplicación de modelos soberanos de bases de IA para mejorar. funciones gubernamentales, entre otras medidas.

En el AI Semiconductor Forum, Samsung confirmó que Google Gemini Nano 2 impulsará la próxima serie Galaxy S25. Para informarle, es el Gemini Nano el que impulsa la serie S24 actual. Gracias a este modelo, toda la gama de teléfonos Android puede realizar una buena cantidad de tareas de IA en el dispositivo. Si bien las funciones actuales que ofrece Galaxy AI hacen un gran trabajo al mejorar la experiencia del usuario, el Galaxy S25 llevará las cosas al siguiente nivel. Por supuesto, todavía no sabemos qué experimentar. Sin embargo, Chulmin Jo, vicepresidente corporativo de System LSI de Samsung Semiconductor, dijo que Samsung celebrará una reunión con Google la próxima semana. Esta reunión podría revelar más sobre las funciones que los próximos teléfonos podrían obtener con Gemini Nano 2. ¿Qué es Google Gemini Nano? ¿Qué podría traer la segunda versión de la serie Galaxy S25? Gemini Nano es un modelo especial de IA. Google lo diseñó para ejecutarse directamente en su teléfono. En la etapa actual, dos de las líneas insignia que ejecutan el modelo son la serie Google Pixel 8 y la serie Galaxy S24. Lo bueno de tener un modelo de IA en el dispositivo es poder realizar tareas relacionadas con la IA sin conexión a Internet. Sí, el nombre Nano podría hacer que parezca un modelo menos capaz. Pero forma parte de la familia más amplia de modelos de IA Gemini de Google DeepMind. Es la versión más ligera. Dada la naturaleza liviana del modelo, Samsung y Google lo integraron directamente en sus teléfonos insignia. Pero ¿qué pasa con Gemini Nano 2, que estará en la serie Galaxy S25? Noticias de la semana de Gizchina Bueno, esta es la primera vez que escuchamos sobre la segunda generación del modelo liviano. Probablemente ofrecerá mejores capacidades de IA generativa. Sin embargo, dado que Samsung ya ha confirmado que estará en el Galaxy S25, pronto aparecerá más información. Podemos esperar mejoras en áreas centrales como el reconocimiento de voz y el procesamiento de imágenes. Por ejemplo, el Gemini Nano 2 de la serie Galaxy S25 podría ofrecer un asistente de voz que te comprenda mejor. Samsung podría aprovechar Gemini Nano 2 para mejorar funciones específicas. El nuevo modelo puede incluso duplicar la seguridad y la privacidad. También vale la pena señalar que Google Gemini Nano puede hacer mucho. La segunda generación de la serie Samsung Galaxy S25 podría hacer aún más. Algunas de las capacidades de la generación actual Nano incluyen: Comprender su mundo y comunicaciones inteligentes Con Galaxy AI en la serie Galaxy S24, Samsung introdujo funciones como Resumir. Esto ayuda a comprender la esencia de los mensajes de texto y las conversaciones. Google también ha introducido Smart Reply, que ofrece mejores sugerencias cuando respondes a un chat. Esta característica podría mejorar aún más en la serie Galaxy S25. Edición de imágenes más inteligente con Galaxy AI La aplicación Galería del Galaxy S24 aprovecha Gemini Nano para ofrecer herramientas avanzadas de edición de fotografías. La tecnología de difusión de texto a imagen Imagen 2 de Google impulsa esto. Y en la etapa actual, los resultados son realmente sorprendentes. Esta característica también puede mejorar mucho en la serie Galaxy S25. Descargo de responsabilidad: Es posible que algunas de las empresas de cuyos productos hablamos nos compensen, pero nuestros artículos y reseñas son siempre nuestras opiniones honestas. Para obtener más detalles, puede consultar nuestras pautas editoriales y conocer cómo utilizamos los enlaces de afiliados.

La solución de inteligencia artificial de Juniper Networks puede mejorar la red WiFi de las empresas

[This is a sponsored article with Juniper Networks.]

En una era digital donde comprar comida a un vendedor ambulante puede ser tan fácil como escanear un código QR con un teléfono, Payments Network Malaysia (PayNet) suele ser la fuerza impulsora detrás de esta perfecta experiencia sin efectivo en Malasia. A modo de contexto, PayNet opera la red de pagos de Malasia y sirve como columna vertebral de los mercados financieros. Después de la pandemia, la institución financiera hizo la transición al trabajo híbrido y reinventó su sede y centro de operaciones de Kuala Lumpur para convertirlos en un lugar de trabajo más colaborativo y flexible. Crédito de imagen: PayNet De manera similar, la Universidad James Cook (JCU) de Singapur quería continuar ofreciendo a sus estudiantes la flexibilidad de elegir dónde aprender, ya sea en línea o mediante clases presenciales. ¿Qué tienen estas instituciones en común? Querían mejorar su juego de networking, tanto dentro como fuera del campus, para brindarles a sus partes interesadas una mejor experiencia digital. Entonces, recurrieron a Juniper Networks (Juniper), una empresa con sede en EE. UU. con un patrimonio neto de 11.830 millones de dólares que ofrece software y tecnología de red, en busca de una solución de red nativa de IA. Pero, ¿cuál es el problema del WiFi? En la década de 2000, cuando el WiFi se hizo popular, la mayoría de las redes estaban diseñadas para tareas básicas como permitir que los usuarios se conectaran a Internet. A medida que más personas comenzaron a utilizar dispositivos personales como teléfonos inteligentes y computadoras portátiles, las demandas de estas redes aumentaron significativamente. Es como cuando una pequeña carretera diseñada para motos de repente tuvo que pasar por muchos coches y camiones, provocando atascos y retrasos. «Vivimos en un mundo donde cada conexión cuenta, y no se trata solo de conectividad, sino de la experiencia de una gran conexión», explicó Yedu Siddalingappa, especialista líder en tecnología empresarial nativa de IA de Juniper. “Imagínese un gran centro de distribución minorista, una red escolar o un hospital que se enfrenta a un corte de red aunque sea por unos minutos. Resultaría en millones de dólares en pérdida de ingresos, estudiantes que no podrían realizar exámenes o trabajadores de la salud que no podrían acceder a información que salva vidas”. Crédito de la imagen: Pexels A medida que los institutos intentan mejorar sus sistemas de red, el equipo de servicios de TI tiene que lidiar con numerosos software y servicios diferentes que no siempre funcionan bien juntos. Y requiere mucho tiempo y esfuerzo ordenar todo manualmente y descubrir qué está causando los problemas. Los estudios muestran que más de la mitad de las personas que administran redes dedican más de 20 horas a la semana a solucionar problemas, y casi una cuarta parte de ese tiempo se dedica a intentar descubrir qué está causando los problemas principales. Les deja poco tiempo y espacio para innovar y diseñar una mejor solución. Ahí es donde entra en juego la infraestructura nativa de IA. Cómo la IA soluciona el problema Con la plataforma de redes nativa de IA de Juniper, la red puede interrumpir de manera inteligente los flujos de tráfico y redirigirlos a otras “carreteras”, distribuyendo así la carga de la red para acomodar más demandas. Se llama solución de infraestructura de LAN inalámbrica y por cable empresarial de Juniper Networks, donde Juniper es nombrado líder 4 veces en el Cuadrante Mágico de Gartner® para infraestructura de LAN inalámbrica y por cable empresarial. Entre sus características se incluye Mist AI, que combina inteligencia artificial, aprendizaje automático y ciencia de datos para ayudar a las plataformas en línea a comunicarse sin problemas con la red y entre sí, y a redirigir el flujo de tráfico para reducir los retrasos en el sistema. «Desde el aislamiento de fallas en tiempo real hasta la detección proactiva de anomalías y acciones correctivas autónomas, la plataforma de redes nativas de IA de Juniper proporciona a las operaciones de campus, sucursales, centros de datos y WAN previsibilidad, confiabilidad y seguridad de nivel superior», agregó Yedu. Cuando funciona según lo previsto en la red WiFi mejorada de PayNet y JCU Singapur, sus usuarios deberían obtener acceso a Internet rápido, seguro y estable en todas partes de sus respectivas sedes y campus con pocas o ninguna interrupción. Además, Mist AI de Juniper viene con administración basada en la nube, lo que permite un control centralizado, una implementación rápida y una fácil escalabilidad. Este sistema basado en la nube permite a sus usuarios gestionar todo desde la nube con facilidad. Esto significa que pueden controlar y acceder a todos los materiales a través de plataformas en línea que se actualizan constantemente en segundo plano con pocos problemas de errores. Cuando estos sistemas funcionan juntos en PayNet, el equipo de 500 personas puede disfrutar de una conectividad continuamente optimizada para computadoras portátiles, impresoras, televisores inteligentes, cámaras de seguridad y otros dispositivos de IoT. El WiFi para invitados también ha pasado de ser una tediosa actividad manual a un proceso seguro y automatizado. Crédito de la imagen: Universidad James Cook de Singapur / Payments Network Malaysia La tecnología también puede hacer que las cosas sean más eficientes. Por ejemplo, Mist AI de Juniper tiene una función llamada Marvis, Virtual Network Assistance (VNA) que actúa como una ayuda inteligente para los ingenieros de redes. En lugar de que los ingenieros tengan que resolver los problemas por su cuenta, Marvis identifica y resuelve rápidamente los problemas de forma remota, eliminando la necesidad de solucionarlos manualmente. Esto puede ahorrar costos a las instituciones a largo plazo. Además, las eficientes capacidades de resolución de problemas de Marvis pueden contribuir a los esfuerzos de sostenibilidad de una organización. Al resolver los problemas de forma remota, se logra una reducción del 85 % en los viajes de los equipos de TI, lo que se alinea perfectamente con las prácticas comerciales sostenibles y minimiza el impacto ambiental. En última instancia, la solución AI-Native Networking de Juniper puede ayudar a las universidades a abordar problemas con la confiabilidad de WiFi y brindar a los usuarios una red segura y fácil de usar, haciendo que las operaciones sean más fluidas. Como resultado, la solución de Juniper permitió a JCU Singapur albergar un aumento de seis veces en el número de dispositivos conectados, totalizando aproximadamente 25.000 dispositivos. Por otro lado, el personal de PayNet ahora tiene una mejor experiencia digital en la oficina. Les ha permitido mantenerse centrados en la innovación de los pagos móviles y en mantener la confiabilidad, seguridad y escalabilidad de la infraestructura financiera de Malasia. Innovaciones continuas para fomentar el crecimiento Por supuesto, los requisitos de las instituciones financieras y de educación superior seguirán evolucionando a medida que pase el tiempo, y las redes de Juniper proporcionan soluciones adaptables para permitir el crecimiento. Por ejemplo, Juniper agregó recientemente su nuevo Marvis Minis a su plataforma de red nativa de IA. Se dice que es el primer y único gemelo de experiencia digital de redes nativas de IA de la industria. En pocas palabras, Marvis Minis puede imitar a los usuarios de la red para comprender cómo está configurada, como un detective que reúne pistas sin necesidad de que alguien se las muestre. Al hacer esto, puede detectar problemas desde el principio, trabajando junto con Mist AI para garantizar que todo funcione sin problemas, como un equipo útil que se asegura de que las carreteras estén despejadas antes de comenzar su viaje, para que no se quede atrapado en el tráfico. La herramienta aprende constantemente a medida que incorpora más datos, utilizando su creciente base de conocimientos para corregir problemas de forma proactiva en tiempo real. Los Marvis Minis son capaces de transformar la forma en que los equipos de TI interactúan con las redes empresariales a través de acceso inalámbrico, acceso por cable y dominios SD-WAN, lo que los convierte en una herramienta esencial para los equipos de TI. Obtenga soluciones de IA personalizadas Cada empresa tiene necesidades de red distintas y necesitaría una solución que pueda adaptarse para integrarse perfectamente con su infraestructura existente. Dicho esto, implementar una red nativa de IA requiere una cuidadosa consideración y planificación. Las empresas pueden comenzar identificando los desafíos específicos que pretenden abordar dentro de su infraestructura de red y visualizando las capacidades que necesitarán en el futuro. Crédito de la imagen: Juniper Networks «La mayoría de las empresas comprenden la importancia de la creación de redes, pero no muchas conocen las soluciones disponibles en la actualidad para lograr los resultados deseados», señaló Yedu. En este sentido, Juniper tiene como objetivo difundir la conciencia global a través de eventos, seminarios web, programas de capacitación y certificación. El próximo evento AI-Native NOW, Live in Singapore de Juniper es un paso en esa dirección. «El evento es principalmente educativo y tiene como objetivo compartir cómo la IA puede optimizar las operaciones de red y ofrecer las mejores experiencias de usuario», compartió. Los profesionales de la industria de TI que quieran obtener más información pueden hacerlo registrándose en AI-Native NOW de Juniper, en vivo en Singapur, el 9 de mayo de 2024. Las inscripciones están sujetas a la aprobación del organizador, que se confirmará mediante el correo electrónico que envíe. Me he registrado con. Regístrese para el evento AI-Native NOW, Live in Singapore de Juniper Networks aquí. Lea sobre otros temas relacionados con la IA que hemos escrito aquí. Crédito de la imagen destacada: Payments Network Malaysia / Juniper Networks

Los empleados de tecnología en APAC saben que trabajar en la región puede implicar dificultades con el idioma. Si bien la mayoría de los negocios transfronterizos se realizan en inglés, aún puede haber dificultades de comunicación, lo que puede llevar a los trabajadores a recurrir a ofertas como Google Translate o ChatGPT en busca de ayuda. Jarek Kutylowski, fundador y director ejecutivo de DeepL. Lo mismo se aplica a las empresas que buscan hacer negocios en los idiomas de la región. Jarek Kutylowski, fundador y director ejecutivo de DeepL, dijo que el modelo de IA de procesamiento de lenguaje natural de la empresa ofrece traducciones de lenguaje natural en 32 idiomas, gracias a años de desarrollo y ajuste desde su lanzamiento en Europa en 2017. Con idiomas adicionales de APAC en su hoja de ruta Para 2024, DeepL está ampliando su presencia a Australia y Singapur, con casos de uso empresarial clave que incluyen la traducción para el crecimiento empresarial transfronterizo. Su suscripción Pro (a partir de 8,74 dólares por usuario al mes y hasta 57,49 dólares para un paquete Ultimate) y API Pro (a partir de 5,49 dólares al mes) permiten a las empresas traducir documentos a escala o integrar traducciones en sus flujos de trabajo. DeepL está expandiendo sus idiomas y mercados de APAC Fundada en Alemania, la campaña de globalización de DeepL la llevó a elegir Japón y Corea del Sur como sus primeros mercados en Asia. Esto se debió a las fuertes economías y conexiones comerciales de los países con el resto del mundo, así como a las importantes barreras lingüísticas, que respaldaron grandes volúmenes de casos de uso de traducción. El impulso de DeepL en APAC hará que esta presencia en el mercado se expanda a Australia y Singapur. Con varios idiomas locales en su haber, incluidos el chino simplificado y el indonesio, además del inglés, japonés y coreano, Kutylowski dijo que la empresa estaba considerando agregar pronto «algunos de los idiomas asiáticos más importantes donde aún no tenemos cobertura». . VER: Cómo Australia se está adaptando rápidamente al mundo de la IA generativa Con más de 900 empleados en todo el mundo, DeepL es utilizado actualmente por 100.000 empresas y organizaciones en todo el mundo, además de millones de personas. Con una creciente base de usuarios empresariales en Japón y Corea del Sur, DeepL espera que su expansión regional aumente su base de ingresos de 1 millón de licencias pagas. El modelo de DeepL está capacitado para traducciones en lenguaje natural. El enfoque de DeepL en proporcionar traducciones en lenguaje natural se reduce a la diferencia entre la «precisión» de la traducción y la «fluidez» en la comunicación lingüística, según la empresa. “En un entorno empresarial, un aspecto principal es si algo que he escrito es correcto. Pero las empresas no sólo quieren corrección en la comunicación; Quieren persuadir, motivar, comunicar claramente e influir en los idiomas que comunican”, dijo Kutylowski. Lo nativo que se siente, lo natural que es, es muy importante”. Cómo DeepL logra traducciones de lenguaje natural DeepL logra un alto nivel de fluidez natural en los idiomas de destino de dos maneras principales: DeepL fue una de las primeras empresas en llevar al mercado la traducción automática neuronal basada en IA en 2017. Desde entonces, ha estado activa en la investigación académica para garantizar que sus modelos no solo tradujeran sino que se expresaran naturalmente en un idioma de destino. DeepL perfecciona sus traducciones de IA involucrando a más de 1000 formadores nativos en todo el mundo. Revisan los resultados que crea el modelo y pueden entrenarlo sobre cómo puede expresarse de forma más natural en su lenguaje. DeepL tiene suscripciones Pro y API para traducción empresarial. DeepL está disponible como una aplicación web gratuita en su sitio web (Figura A) y también se puede utilizar como extensión del navegador. Sin embargo, para las empresas, la creciente presencia de DeepL en APAC tiene como objetivo en última instancia generar interés en las suscripciones a DeepL Pro y API Pro, que ofrecen funciones avanzadas diseñadas para ayudar a las empresas locales a escalar e integrar la traducción de forma segura. Figure A DeepL se puede utilizar en la web o actualizar con suscripciones pagas. Además de las traducciones en lenguaje natural, la suscripción Pro de DeepL ofrece: Seguridad de los datos: DeepL elimina todo el texto que procesa de los servidores operados por DeepL una vez completada la traducción. La empresa promete que ningún texto de cliente se transmitirá a terceros ni se utilizará como datos de entrenamiento de IA. Traducciones de texto ilimitadas: la oferta de DeepL Pro incluye traducciones de texto ilimitadas. Esto incluye la capacidad de traducir más documentos con tamaños de archivo más grandes, preservando al mismo tiempo el formato del documento original. Control de personalización: las empresas pueden adaptar los resultados de la IA para mantener la coherencia de la marca y estandarizar los mensajes mediante la personalización, lo que incluye tener control sobre aspectos como la terminología de marca específica. La suscripción API Pro de DeepL ofrece acceso a la API REST de DeepL junto con seguridad de datos y sin restricciones de volumen, aunque los usuarios pagan un cargo de uso de 25 dólares estadounidenses por cada millón de caracteres. La suscripción permite a las empresas integrar la funcionalidad de traducción de DeepL con sitios web, aplicaciones y herramientas de comunicación interna con unos pocos clics. DeepL tiene opciones para integrarse en los flujos de trabajo de clientes y usuarios. Hay muchos casos de uso posibles para DeepL. “Potencialmente, nuestros usuarios realizan muchos trabajos diferentes. Pueden escribir en Gmail, escribir una nota en Salesforce o crear un documento en Microsoft Office; los casos de uso son muy amplios”, explicó Kutylowski. El traductor se puede utilizar en el propio sitio web. Sin embargo, también se puede acceder a él a través de extensiones del navegador, que pueden traducir inmediatamente cualquier cosa ingresada en un navegador web que funcione con herramientas de software comunes como Google Docs, Microsoft Office o Salesforce. DeepL también trabaja con los clientes para integrar traducciones en sus propios sistemas y flujos de trabajo. Kutylowski dio el ejemplo de empresas donde DeepL está integrado y trabaja en segundo plano en los centros de atención al cliente, brindando servicio al cliente con traducciones instantáneas. Más cobertura de Australia Dos casos de uso empresarial típicos para los productos de traducción de DeepL DeepL está viendo dos grupos principales de casos de uso empresarial para sus ofertas de suscripción. 1: Empresas que buscan ingresar a nuevos mercados en nuevos idiomas Las empresas que desean expandirse a nuevos mercados en idiomas no nativos pueden utilizar DeepL para respaldar sus actividades. Esto puede significar no tener que contratar traductores de inmediato, o incorporar agencias, representantes y agentes de atención al cliente que dominen completamente el idioma nativo. «Puede tomar su equipo existente y equiparlo con una herramienta que les ayude a hablar con clientes o clientes potenciales, y utilizarla para ingresar a nuevos mercados», dijo Kutylowski. «Por ejemplo, puede llegar incluso a traducir previamente documentos técnicos o materiales para que los clientes se incorporen a sus propias soluciones». 2: Internamente dentro de organizaciones internacionales con barreras lingüísticas Algunas empresas multijurisdiccionales consideran que las barreras lingüísticas son un problema interno. Kutylowski dijo que la herramienta puede garantizar que las comunicaciones diarias, como los correos electrónicos, se escriban rápidamente en un idioma nativo y se traduzcan de inmediato, con menos esfuerzo y tiempo necesarios para los usuarios.

Las empresas están un paso más cerca de la computación cuántica en la nube, gracias a un avance logrado en su seguridad y privacidad por científicos de la Universidad de Oxford. Los investigadores utilizaron un enfoque denominado «computación cuántica ciega» para conectar dos entidades de computación cuántica (Figura A); Esto simula la situación en la que un empleado en casa o en una oficina se conecta de forma remota a un servidor cuántico a través de la nube. Con este método, el proveedor del servidor cuántico no necesita conocer ningún detalle del cálculo para realizarlo, manteniendo seguro el trabajo propietario del usuario. El usuario también puede verificar fácilmente la autenticidad de su resultado, confirmando que no es erróneo ni está dañado. Figura A Los investigadores utilizaron un enfoque denominado “computación cuántica ciega” para conectar dos entidades de computación cuántica de una manera completamente segura. Imagen: David Nadlinger/Universidad de Oxford Garantizar la seguridad y privacidad de los cálculos cuánticos es uno de los obstáculos más importantes que ha frenado esta poderosa tecnología hasta ahora, por lo que este trabajo podría llevar a que finalmente entre en la corriente principal. A pesar de haber sido probado solo a pequeña escala, los investigadores dicen que su experimento tiene el potencial de ampliarse a grandes cálculos cuánticos. Se podrían desarrollar dispositivos enchufables que protejan los datos de un trabajador mientras accede a los servicios de computación cuántica en la nube. El profesor David Lucas, codirector del equipo de investigación de Física de la Universidad de Oxford, dijo en un comunicado de prensa: «Hemos demostrado por primera vez que se puede acceder a la computación cuántica en la nube de una manera práctica y escalable, lo que también brindará a las personas completa seguridad y privacidad de los datos, además de la capacidad de verificar su autenticidad”. ¿Qué es la computación cuántica en la nube? Las computadoras clásicas procesan información como bits binarios representados como unos y ceros, pero las computadoras cuánticas lo hacen utilizando bits cuánticos o qubits. Los qubits existen como 1 y 0 al mismo tiempo, pero con una probabilidad de ser uno u otro que está determinada por su estado cuántico. Esta propiedad permite a los ordenadores cuánticos abordar determinados cálculos mucho más rápido que los ordenadores clásicos, ya que pueden resolver problemas simultáneamente. La computación cuántica en la nube es donde se proporcionan recursos cuánticos a los usuarios de forma remota a través de Internet; esto permite que cualquiera pueda utilizar la computación cuántica sin necesidad de hardware o experiencia especializados. DESCARGA GRATUITA: Computación cuántica: una guía privilegiada ¿Por qué la ‘computación cuántica ciega’ es más segura? Con la típica computación cuántica en la nube, el usuario debe divulgar el problema que está tratando de resolver al proveedor de la nube; esto se debe a que la infraestructura del proveedor necesita comprender los detalles del problema para poder asignar los recursos y parámetros de ejecución adecuados. Naturalmente, en el caso de trabajos propietarios, esto presenta un problema de seguridad. Este riesgo de seguridad se minimiza con el método de computación cuántica ciega porque el usuario controla de forma remota el procesador cuántico del servidor durante un cálculo. La información necesaria para mantener los datos seguros, como la entrada, la salida y los detalles algorítmicos, solo necesita ser conocida por el cliente porque el servidor no toma ninguna decisión con ella. Cómo funciona la computación cuántica en la nube a ciegas. «Nunca en la historia se han debatido con más urgencia las cuestiones relativas a la privacidad de los datos y el código que en la era actual de la computación en la nube y la inteligencia artificial», dijo el profesor Lucas en el comunicado de prensa. «A medida que las computadoras cuánticas se vuelvan más capaces, la gente buscará utilizarlas con total seguridad y privacidad a través de las redes, y nuestros nuevos resultados marcan un cambio radical en la capacidad a este respecto». ¿Cómo podría afectar la computación cuántica a los negocios? La computación cuántica es mucho más poderosa que la computación convencional y podría revolucionar la forma en que trabajamos si logra salir de la fase de investigación. Los ejemplos incluyen resolver problemas de la cadena de suministro, optimizar rutas y asegurar las comunicaciones. En febrero, el gobierno del Reino Unido anunció una inversión de 45 millones de libras (57 millones de dólares) en computación cuántica; el dinero se destina a encontrar usos prácticos para la computación cuántica y crear una “economía habilitada para lo cuántico” para 2033. En marzo, la computación cuántica fue destacada en la Declaración Ministerial, y los países del G7 acordaron trabajar juntos para promover el desarrollo de tecnologías cuánticas y Fomentar la colaboración entre la academia y la industria. Este mes, la segunda computadora cuántica comercial del Reino Unido entró en funcionamiento. Debido a los grandes requisitos de energía y refrigeración, actualmente hay muy pocos ordenadores cuánticos disponibles comercialmente. Sin embargo, varios proveedores líderes de nube ofrecen el llamado servicio cuántico a clientes e investigadores corporativos. Cirq de Google, por ejemplo, es una plataforma de computación cuántica de código abierto, mientras que Amazon Braket permite a los usuarios probar sus algoritmos en un simulador cuántico local. IBM, Microsoft y Alibaba también tienen ofertas de servicio cuántico. MIRAR: Lo que los desarrolladores de software clásico necesitan saber sobre la computación cuántica Pero antes de que la computación cuántica pueda ampliarse y usarse para aplicaciones comerciales, es imperativo garantizar que se pueda lograr salvaguardando al mismo tiempo la privacidad y seguridad de los datos de los clientes. Esto es lo que los investigadores de la Universidad de Oxford esperaban lograr en su nuevo estudio, publicado en Physical Review Letters. Cobertura de seguridad de lectura obligada, el Dr. Peter Dmota, líder del estudio, dijo a TechRepublic en un correo electrónico: «Las sólidas garantías de seguridad reducirán la barrera al uso de potentes servicios de computación cuántica en la nube, una vez que estén disponibles, para acelerar el desarrollo de nuevas tecnologías, como las baterías». y medicamentos, y para aplicaciones que involucran datos altamente confidenciales, como información médica privada, propiedad intelectual y defensa. Esas aplicaciones también existen sin seguridad adicional, pero es menos probable que se utilicen tan ampliamente. “La computación cuántica tiene el potencial de mejorar drásticamente el aprendizaje automático. Esto impulsaría el desarrollo de una inteligencia artificial mejor y más adaptada, que ya estamos viendo que afecta a las empresas de todos los sectores. “Es concebible que la computación cuántica tenga un impacto en nuestras vidas en los próximos cinco a diez años, pero es difícil pronosticar la naturaleza exacta de las innovaciones futuras. Espero un proceso de adaptación continuo a medida que los usuarios comiencen a aprender cómo utilizar esta nueva herramienta y cómo aplicarla en sus trabajos, similar a cómo la IA se está volviendo cada vez más relevante en el lugar de trabajo convencional en este momento. «Actualmente, nuestra investigación se basa en suposiciones bastante generales, pero a medida que las empresas comiencen a explorar el potencial de la computación cuántica para ellas, surgirán requisitos más específicos que impulsarán la investigación hacia nuevas direcciones». ¿Cómo funciona la computación cuántica en la nube a ciegas? La computación cuántica en la nube a ciegas requiere conectar una computadora cliente que pueda detectar fotones o partículas de luz a un servidor de computación cuántica con un cable de fibra óptica (Figura B). El servidor genera fotones individuales, que se envían a través de la red de fibra y son recibidos por el cliente. Figura B Los investigadores conectaron una computadora cliente que podía detectar fotones, o partículas de luz, a un servidor de computación cuántica con un cable de fibra óptica. Imagen: David Nadlinger/Universidad de Oxford Luego, el cliente mide la polarización u orientación de los fotones, lo que le indica cómo manipular remotamente el servidor de manera que produzca el cálculo deseado. Esto se puede hacer sin que el servidor necesite acceder a ninguna información sobre el cálculo, lo que lo hace seguro. Para brindar una seguridad adicional de que los resultados del cálculo no son erróneos o han sido alterados, se pueden realizar pruebas adicionales. Si bien la manipulación no dañaría la seguridad de los datos en un cálculo cuántico ciego, aún podría corromper el resultado y dejar al cliente inconsciente. «Las leyes de la mecánica cuántica no permiten la copia de información y cualquier intento de observar el estado de la memoria por parte del servidor o de un espía corrompería el cálculo», explicó el Dr. Dmota a TechRepublic en un correo electrónico. “En ese caso, el usuario notaría que el servidor no está funcionando correctamente, utilizando una función llamada ‘verificación’, y cancelaría el uso de su servicio si tuviera alguna duda. “Dado que el servidor es ‘ciego’ al cálculo, es decir, no es capaz de distinguir diferentes cálculos, el cliente puede evaluar la confiabilidad del servidor ejecutando pruebas simples cuyos resultados se pueden verificar fácilmente. “Estas pruebas se pueden intercalar con el cálculo real hasta que haya evidencia suficiente de que el servidor está funcionando correctamente y se pueda confiar en que los resultados del cálculo real son correctos. De esta manera, el cliente puede detectar errores honestos e intentos maliciosos de alterar el cálculo”. Figura C El Dr. Peter Drmota (en la foto) dijo que la investigación es “un gran paso adelante tanto en la computación cuántica como en mantener nuestra información segura en línea”. Imagen: Martin Small/Universidad de Oxford ¿Qué descubrieron los investigadores a través de su experimento ciego de computación cuántica en la nube? Los investigadores descubrieron que los cálculos que produjo su método “podían verificarse de manera sólida y confiable”, según el artículo. Esto significa que el cliente puede confiar en que los resultados no han sido alterados. También es escalable, ya que la cantidad de elementos cuánticos que se manipulan para realizar cálculos se puede aumentar «sin aumentar la cantidad de qubits físicos en el servidor y sin modificaciones en el hardware del cliente», escribieron los científicos. El Dr. Drmota dijo en el comunicado de prensa: “Utilizando la computación cuántica ciega, los clientes pueden acceder a computadoras cuánticas remotas para procesar datos confidenciales con algoritmos secretos e incluso verificar que los resultados sean correctos, sin revelar ninguna información útil. Hacer realidad este concepto es un gran paso adelante tanto en la computación cuántica como en mantener nuestra información segura en línea”. La investigación fue financiada por el Centro de Simulación y Computación Cuántica del Reino Unido, una colaboración de 17 universidades respaldadas por organizaciones comerciales y gubernamentales. Es uno de los cuatro centros de tecnología cuántica del Programa Nacional de Tecnologías Cuánticas del Reino Unido.

Con el fin de proporcionar marcos abiertos para capacidades de IA generativa en todos los ecosistemas, como la generación de recuperación aumentada, la Fundación Linux, Intel y otras empresas y grupos han creado la Plataforma Abierta para la IA Empresarial. ¿Qué es la plataforma abierta para la IA empresarial? OPEA es un proyecto sandbox dentro de LF AI & Data Foundation, parte de la Fundación Linux. El plan es fomentar la adopción de tecnologías de IA generativa abiertas y crear “sistemas GenAI flexibles y escalables que aprovechen la mejor innovación de código abierto de todo el ecosistema”, según un comunicado de prensa de OPEA. A la iniciativa se han sumado las siguientes empresas y grupos: Anyscale. Nubera. DatosStax. Laboratorio de datos de Domino. Abrazando la cara. Intel. KX. Fundación MaríaDB. MinIO. Qdrant. Sombrero rojo. SAS. VMware (adquirida por Broadcom). Datos de ladrillo amarillo. Zilliz. Idealmente, la iniciativa podría resultar en una mayor interoperabilidad entre productos y servicios de esos proveedores. «A medida que GenAI madura, la integración en la TI existente es un paso natural y necesario», dijo Kaj Arnö, director ejecutivo de la Fundación MariaDB, en un comunicado de prensa de OPEA. ¿Qué creó la OPEA? La idea es encontrar nuevos casos de uso para la IA, particularmente verticalmente en la pila de tecnología, a través de un modelo de gobernanza abierto y colaborativo. Para ello, OPEA creó un marco de bloques de construcción componibles para sistemas generativos de IA, desde la capacitación hasta el almacenamiento de datos y las indicaciones. OPEA también creó una evaluación para calificar el rendimiento, las características, la confiabilidad y la preparación a nivel empresarial de los sistemas de IA generativa y los planos para la estructura de la pila de componentes y los flujos de trabajo de RAG. Intel, en particular, proporcionará lo siguiente: Un marco conceptual técnico. Implementaciones de referencia para implementar IA generativa en procesadores Intel Xeon y aceleradores Intel Gaudi AI. Más capacidad de infraestructura en Intel Tiber Developer Cloud para el desarrollo del ecosistema, la aceleración de la IA y la validación de RAG y futuras canalizaciones. «Abogar por una base de código abierto y estándares, desde conjuntos de datos hasta formatos, API y modelos, permite a las organizaciones y empresas construir de forma transparente», dijo AB Periasamy, director ejecutivo y cofundador de MinIO, en un comunicado de prensa de OMEA. «La infraestructura de datos de IA también debe construirse sobre estos principios abiertos». Más cobertura de IA de lectura obligada ¿Por qué es tan importante RAG? La generación de recuperación aumentada, en la que los modelos de IA generativa verifican con datos públicos o de la empresa del mundo real antes de proporcionar una respuesta, está demostrando ser valiosa en el uso empresarial de la IA generativa. RAG ayuda a las empresas a confiar en que la IA generativa no arrojará respuestas sin sentido que parezcan convincentes. OPEA espera que RAG (Figura A) pueda permitir que la IA generativa extraiga más valor de los depósitos de datos que las empresas ya tienen. Figura A Una tubería que muestra la arquitectura RAG. Imagen: OMEA “Estamos encantados de darle la bienvenida a OPEA a LF AI & Data con la promesa de ofrecer canales de generación de recuperación aumentada (RAG) de código abierto, estandarizados, modulares y heterogéneos para empresas con un enfoque en el desarrollo de modelos abiertos, reforzados y optimizados. soporte de varios compiladores y cadenas de herramientas”, dijo el director ejecutivo de LF AI & Data, Ibrahim Haddad, en un comunicado de prensa. No existen estándares de facto para implementar RAG, señaló Intel en su publicación de anuncio; La OPEA pretende llenar ese vacío. VER: Nombramos a RAG una de las principales tendencias de IA de 2024. «Estamos viendo un enorme entusiasmo entre nuestra base de clientes por RAG», dijo Chris Wolf, director global de IA y servicios avanzados de Broadcom, en un comunicado de prensa de OPEA. “Las estructuras detrás de RAG se pueden aplicar universalmente a una variedad de casos de uso, lo que hace que un enfoque impulsado por la comunidad que impulse la coherencia y la interoperabilidad de las aplicaciones RAG sea un importante paso adelante para ayudar a todas las organizaciones a aprovechar de forma segura los numerosos beneficios que la IA tiene para ofrecer. “Añadió Lobo. ¿Cómo pueden participar las organizaciones en OPEA? Las organizaciones pueden participar contribuyendo en GitHub o comunicándose con OPEA.

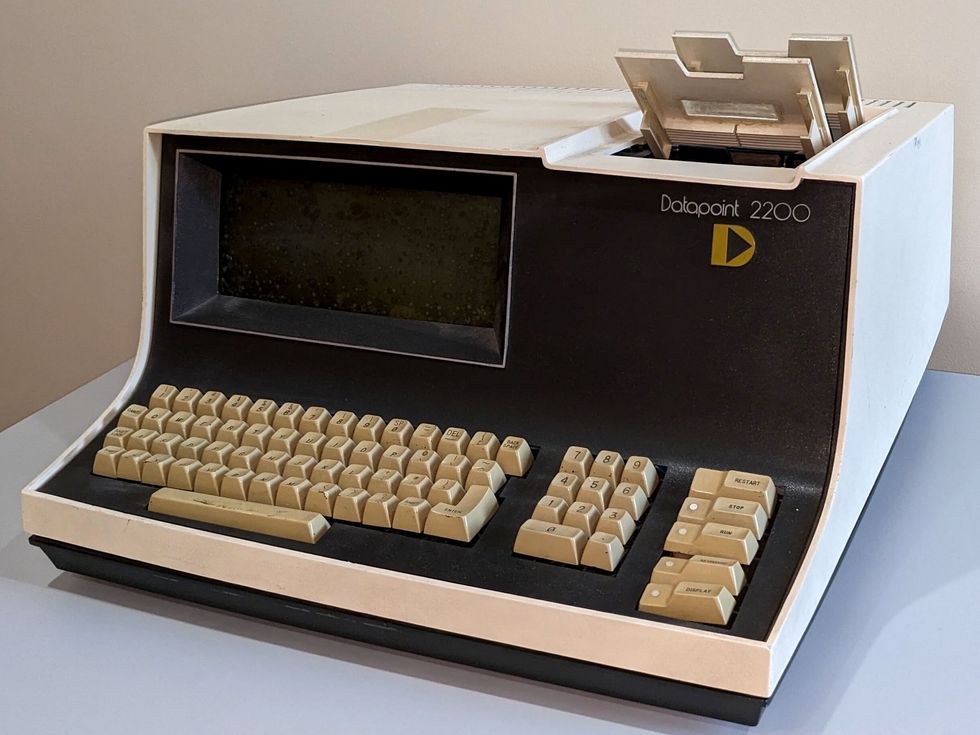

Como presidente del comité de historia de la Sección Lone Star del IEEE, en San Antonio, Texas, soy responsable de documentar, preservar y aumentar la visibilidad de las tecnologías desarrolladas en el área local. Una de esas tecnologías es el Datapoint 2200, un terminal programable que sentó las bases de la revolución de las computadoras personales. Lanzada en 1970 por Computer Terminal Corp. (CTC) en San Antonio, la máquina jugó un papel importante en los primeros días de las microcomputadoras. El sistema pionero integraba una CPU, memoria y dispositivos de entrada/salida en una sola unidad, convirtiéndolo en un dispositivo compacto y autónomo. A menudo se asocia a Apple, IBM y otras empresas con la popularización de las PC; No debemos pasar por alto las innovaciones pioneras introducidas por Datapoint. Puede que la máquina se haya borrado de la memoria, pero no se puede negar su influencia en la evolución de la tecnología informática. El comité de miembros vitalicios de la Región 5 del IEEE honró la máquina en 2022 con su premio Stepping Stone, pero me gustaría que más miembros conocieran las innovaciones introducidas por el diseño de la máquina. De mainframes a microcomputadorasAntes de la computadora personal, existían las mainframes. Las colosales máquinas, con sus voluminosos monitores verdes alojados en habitaciones meticulosamente refrigeradas, personificaban la vanguardia de la tecnología en ese momento. Tuve la suerte de trabajar con mainframes durante mi segundo año como estudiante de ingeniería eléctrica en la Universidad de los Emiratos Árabes Unidos en Al Ain, Abu Dhabi, en 1986. Las máquinas ocupaban salas enteras, eclipsando a las computadoras personales que conocemos hoy. Acceder a las computadoras centrales implicaba trabajar con terminales basadas en texto que carecían de interfaces gráficas y tenían capacidades limitadas. Esas terminales relativamente diminutas que interactuaban con las máquinas a menudo proporcionaban un toque de diversión a los estudiantes. Las salas de la computadora central servían como lugares sociales, fomentando interacciones, colaboraciones y competencias amistosas. Operar las terminales requería dominar comandos específicos y lenguajes de codificación. El proceso de enviar trabajos informáticos y esperar resultados sin respuesta inmediata puede resultar divertido y frustrante al mismo tiempo. Los estudiantes a menudo se referían con humor al “agujero negro”, donde sus trabajos parecían desaparecer hasta que los resultados se materializaban. Decodificar mensajes de error enigmáticos se convirtió en un desafío, pero los estudiantes disfrutaban descifrarlos y compartir ejemplos divertidos. A pesar de la potencia de los mainframes, tenían capacidades de procesamiento y memoria restringidas en comparación con las computadoras actuales. La introducción de las computadoras personales durante mi último año fue un juego. cambiador. No sabía que eventualmente me llevaría a San Antonio, Texas, lugar de nacimiento de la PC, donde comenzaría un nuevo capítulo de mi vida. La primera PCI En San Antonio, un grupo de ingenieros visionarios de la NASA fundó CTC con el objetivo de revolucionando la informática de escritorio. Introdujeron el Datapoint 3300 como reemplazo de los terminales Teletype. Dirigida por Phil Ray y Gus Roche, la empresa construyó más tarde la primera computadora de escritorio personal, la Datapoint 2200. También desarrollaron tecnología LAN y pretendieron reemplazar los equipos de oficina tradicionales con dispositivos electrónicos operables desde una sola terminal. El Datapoint 2200 introdujo varios elementos de diseño que luego fueron adoptados por otros fabricantes de computadoras. Fue una de las primeras computadoras en utilizar un teclado similar al de una máquina de escribir y un monitor para la interacción del usuario, que se convirtieron en dispositivos de entrada y salida estándar para las computadoras personales. Sentaron un precedente para interfaces informáticas fáciles de usar. La máquina también tenía unidades de casete para almacenamiento, predecesoras de las unidades de disco. La computadora tenía opciones para redes, módems, interfaces, impresoras y un lector de tarjetas. Utilizaba diferentes tamaños de memoria y empleaba una arquitectura de procesador de 8 bits. Inicialmente, la CPU del Datapoint estaba destinada a ser un chip personalizado, que finalmente llegó a conocerse como microprocesador. En ese momento, no existían tales chips, por lo que CTC contrató a Intel para producir uno. Ese chip fue el Intel 8008, que evolucionó hasta convertirse en el Intel 8080. Introducido en 1974, el 8080 formó la base de las computadoras pequeñas, según una entrada sobre los primeros microprocesadores en la Wiki de Historia de la Ingeniería y la Tecnología. Esos primeros microprocesadores de 8 bits están celebrando su 50 aniversario este año. El 2200 se comercializó principalmente para uso empresarial y su introducción ayudó a acelerar la adopción de sistemas informáticos en varias industrias, según Lamont Wood, autor de Datapoint: The Lost Story of the Texans Who Invented the Personal Computer Revolution. La máquina popularizó el concepto de terminales de computadora, que permitían a múltiples usuarios acceder a un sistema informático central de forma remota, escribió Wood. También introdujo la idea de una terminal como medio de interacción con una computadora central, permitiendo a los usuarios ingresar comandos y recibir resultados. El concepto sentó las bases para el desarrollo de las redes y la informática distribuida. Con el tiempo, condujo a la creación de LAN y redes de área amplia, que permitieron compartir recursos e información entre organizaciones. El concepto de terminales informáticos influyó en el desarrollo de las modernas tecnologías de redes, incluida Internet, señaló Wood. Cómo Datapoint inspiró a Apple e IBM Aunque el Datapoint 2200 no era una computadora orientada al consumidor, sus principios de diseño y su influencia desempeñaron un papel en el desarrollo de las computadoras personales. Su naturaleza compacta y autónoma demostró la viabilidad y el potencial de este tipo de máquinas. El Datapoint despertó la imaginación de investigadores y empresarios, lo que condujo a la disponibilidad generalizada de computadoras personales. A continuación se muestran algunos ejemplos de cómo los fabricantes construyeron sobre las bases establecidas por el Datapoint 2200: Apple se inspiró en las primeras microcomputadoras. El Apple II, presentado en 1977, fue uno de los primeros ordenadores personales de éxito. Incorporaba un teclado, un monitor y una interfaz de cinta de casete para almacenamiento, similar al Datapoint 2200. En 1984, Apple presentó el Macintosh, que presentaba una interfaz gráfica de usuario y un mouse, revolucionando la forma en que los usuarios interactuaban con las computadoras. IBM entró en el mercado de computadoras personales en 1981. Su PC también fue influenciada por los principios de diseño de las microcomputadoras. La máquina presentaba una arquitectura abierta, lo que permitía una fácil expansión y personalización. El éxito de la PC la estableció como un estándar en la industria. Microsoft jugó un papel crucial en el desarrollo de software para las primeras microcomputadoras. Su MS-DOS proporcionó una plataforma estandarizada para el desarrollo de software y era compatible con IBM PC y otras microcomputadoras. El sistema operativo ayudó a establecer a Microsoft como un actor dominante en la industria del software. Commodore International, un destacado fabricante de computadoras en la década de 1980, lanzó el Commodore 64 en 1982. Fue una microcomputadora exitosa que se basó en los conceptos del Datapoint 2200 y otros primeros. máquinas. El Commodore 64 presentaba un teclado integrado, gráficos en color y capacidades de sonido, lo que lo convertía en una opción popular para juegos e informática doméstica. Xerox hizo contribuciones significativas al avance de las interfaces informáticas. Su Alto, desarrollado en 1973, introdujo el concepto de interfaz gráfica de usuario, con ventanas, iconos y un mouse para la interacción. Aunque Alto no fue un éxito comercial, su influencia fue sustancial y ayudó a sentar las bases para los sistemas basados en GUI, incluidos Macintosh y Microsoft Windows. El Datapoint 2200 merece ser recordado por sus contribuciones a la historia de la informática.