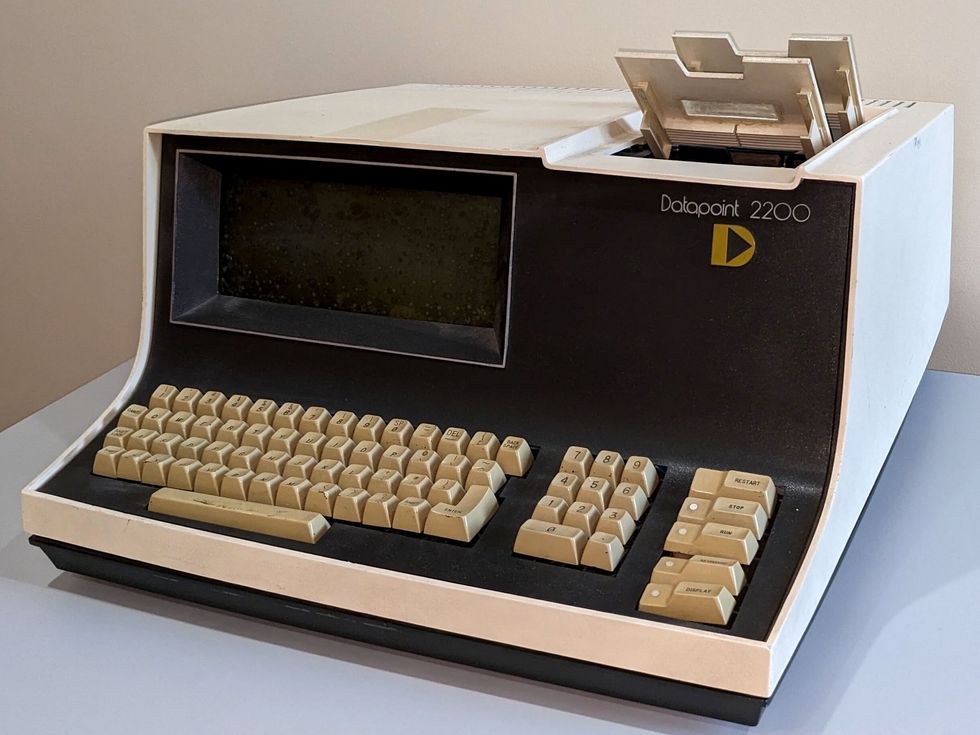

Como presidente del comité de historia de la Sección Lone Star del IEEE, en San Antonio, Texas, soy responsable de documentar, preservar y aumentar la visibilidad de las tecnologías desarrolladas en el área local. Una de esas tecnologías es el Datapoint 2200, un terminal programable que sentó las bases de la revolución de las computadoras personales. Lanzada en 1970 por Computer Terminal Corp. (CTC) en San Antonio, la máquina jugó un papel importante en los primeros días de las microcomputadoras. El sistema pionero integraba una CPU, memoria y dispositivos de entrada/salida en una sola unidad, convirtiéndolo en un dispositivo compacto y autónomo. A menudo se asocia a Apple, IBM y otras empresas con la popularización de las PC; No debemos pasar por alto las innovaciones pioneras introducidas por Datapoint. Puede que la máquina se haya borrado de la memoria, pero no se puede negar su influencia en la evolución de la tecnología informática. El comité de miembros vitalicios de la Región 5 del IEEE honró la máquina en 2022 con su premio Stepping Stone, pero me gustaría que más miembros conocieran las innovaciones introducidas por el diseño de la máquina. De mainframes a microcomputadorasAntes de la computadora personal, existían las mainframes. Las colosales máquinas, con sus voluminosos monitores verdes alojados en habitaciones meticulosamente refrigeradas, personificaban la vanguardia de la tecnología en ese momento. Tuve la suerte de trabajar con mainframes durante mi segundo año como estudiante de ingeniería eléctrica en la Universidad de los Emiratos Árabes Unidos en Al Ain, Abu Dhabi, en 1986. Las máquinas ocupaban salas enteras, eclipsando a las computadoras personales que conocemos hoy. Acceder a las computadoras centrales implicaba trabajar con terminales basadas en texto que carecían de interfaces gráficas y tenían capacidades limitadas. Esas terminales relativamente diminutas que interactuaban con las máquinas a menudo proporcionaban un toque de diversión a los estudiantes. Las salas de la computadora central servían como lugares sociales, fomentando interacciones, colaboraciones y competencias amistosas. Operar las terminales requería dominar comandos específicos y lenguajes de codificación. El proceso de enviar trabajos informáticos y esperar resultados sin respuesta inmediata puede resultar divertido y frustrante al mismo tiempo. Los estudiantes a menudo se referían con humor al “agujero negro”, donde sus trabajos parecían desaparecer hasta que los resultados se materializaban. Decodificar mensajes de error enigmáticos se convirtió en un desafío, pero los estudiantes disfrutaban descifrarlos y compartir ejemplos divertidos. A pesar de la potencia de los mainframes, tenían capacidades de procesamiento y memoria restringidas en comparación con las computadoras actuales. La introducción de las computadoras personales durante mi último año fue un juego. cambiador. No sabía que eventualmente me llevaría a San Antonio, Texas, lugar de nacimiento de la PC, donde comenzaría un nuevo capítulo de mi vida. La primera PCI En San Antonio, un grupo de ingenieros visionarios de la NASA fundó CTC con el objetivo de revolucionando la informática de escritorio. Introdujeron el Datapoint 3300 como reemplazo de los terminales Teletype. Dirigida por Phil Ray y Gus Roche, la empresa construyó más tarde la primera computadora de escritorio personal, la Datapoint 2200. También desarrollaron tecnología LAN y pretendieron reemplazar los equipos de oficina tradicionales con dispositivos electrónicos operables desde una sola terminal. El Datapoint 2200 introdujo varios elementos de diseño que luego fueron adoptados por otros fabricantes de computadoras. Fue una de las primeras computadoras en utilizar un teclado similar al de una máquina de escribir y un monitor para la interacción del usuario, que se convirtieron en dispositivos de entrada y salida estándar para las computadoras personales. Sentaron un precedente para interfaces informáticas fáciles de usar. La máquina también tenía unidades de casete para almacenamiento, predecesoras de las unidades de disco. La computadora tenía opciones para redes, módems, interfaces, impresoras y un lector de tarjetas. Utilizaba diferentes tamaños de memoria y empleaba una arquitectura de procesador de 8 bits. Inicialmente, la CPU del Datapoint estaba destinada a ser un chip personalizado, que finalmente llegó a conocerse como microprocesador. En ese momento, no existían tales chips, por lo que CTC contrató a Intel para producir uno. Ese chip fue el Intel 8008, que evolucionó hasta convertirse en el Intel 8080. Introducido en 1974, el 8080 formó la base de las computadoras pequeñas, según una entrada sobre los primeros microprocesadores en la Wiki de Historia de la Ingeniería y la Tecnología. Esos primeros microprocesadores de 8 bits están celebrando su 50 aniversario este año. El 2200 se comercializó principalmente para uso empresarial y su introducción ayudó a acelerar la adopción de sistemas informáticos en varias industrias, según Lamont Wood, autor de Datapoint: The Lost Story of the Texans Who Invented the Personal Computer Revolution. La máquina popularizó el concepto de terminales de computadora, que permitían a múltiples usuarios acceder a un sistema informático central de forma remota, escribió Wood. También introdujo la idea de una terminal como medio de interacción con una computadora central, permitiendo a los usuarios ingresar comandos y recibir resultados. El concepto sentó las bases para el desarrollo de las redes y la informática distribuida. Con el tiempo, condujo a la creación de LAN y redes de área amplia, que permitieron compartir recursos e información entre organizaciones. El concepto de terminales informáticos influyó en el desarrollo de las modernas tecnologías de redes, incluida Internet, señaló Wood. Cómo Datapoint inspiró a Apple e IBM Aunque el Datapoint 2200 no era una computadora orientada al consumidor, sus principios de diseño y su influencia desempeñaron un papel en el desarrollo de las computadoras personales. Su naturaleza compacta y autónoma demostró la viabilidad y el potencial de este tipo de máquinas. El Datapoint despertó la imaginación de investigadores y empresarios, lo que condujo a la disponibilidad generalizada de computadoras personales. A continuación se muestran algunos ejemplos de cómo los fabricantes construyeron sobre las bases establecidas por el Datapoint 2200: Apple se inspiró en las primeras microcomputadoras. El Apple II, presentado en 1977, fue uno de los primeros ordenadores personales de éxito. Incorporaba un teclado, un monitor y una interfaz de cinta de casete para almacenamiento, similar al Datapoint 2200. En 1984, Apple presentó el Macintosh, que presentaba una interfaz gráfica de usuario y un mouse, revolucionando la forma en que los usuarios interactuaban con las computadoras. IBM entró en el mercado de computadoras personales en 1981. Su PC también fue influenciada por los principios de diseño de las microcomputadoras. La máquina presentaba una arquitectura abierta, lo que permitía una fácil expansión y personalización. El éxito de la PC la estableció como un estándar en la industria. Microsoft jugó un papel crucial en el desarrollo de software para las primeras microcomputadoras. Su MS-DOS proporcionó una plataforma estandarizada para el desarrollo de software y era compatible con IBM PC y otras microcomputadoras. El sistema operativo ayudó a establecer a Microsoft como un actor dominante en la industria del software. Commodore International, un destacado fabricante de computadoras en la década de 1980, lanzó el Commodore 64 en 1982. Fue una microcomputadora exitosa que se basó en los conceptos del Datapoint 2200 y otros primeros. máquinas. El Commodore 64 presentaba un teclado integrado, gráficos en color y capacidades de sonido, lo que lo convertía en una opción popular para juegos e informática doméstica. Xerox hizo contribuciones significativas al avance de las interfaces informáticas. Su Alto, desarrollado en 1973, introdujo el concepto de interfaz gráfica de usuario, con ventanas, iconos y un mouse para la interacción. Aunque Alto no fue un éxito comercial, su influencia fue sustancial y ayudó a sentar las bases para los sistemas basados en GUI, incluidos Macintosh y Microsoft Windows. El Datapoint 2200 merece ser recordado por sus contribuciones a la historia de la informática.

Etiqueta: robótica Página 1 de 4

Video Friday es tu selección semanal de increíbles videos de robótica, recopilados por tus amigos de IEEE Spectrum Robotics. También publicamos un calendario semanal de los próximos eventos de robótica para los próximos meses. Envíenos sus eventos para su inclusión.RoboCup German Open: 17–21 de abril de 2024, KASSEL, ALEMANIAUVSI XPONENTIAL 2024: 22–25 de abril de 2024, SAN DIEGOEurobot Open 2024: 8–11 de mayo de 2024, LA ROCHE-SUR-YON, FRANCIAICRA 2024 : 13–17 de mayo de 2024, YOKOHAMA, JAPÓNRoboCup 2024: 17–22 de julio de 2024, EINDHOVEN, PAÍSES BAJOS Cybathlon 2024: 25–27 de octubre de 2024, ZURICH ¡Disfruta de los vídeos de hoy! Creo que sugerir que los robots no pueden caer es mucho menos útil que sugerir que Los robots pueden caerse y volver a levantarse rápida y fácilmente.[ Deep Robotics ]Sanctuary AI dice que este video muestra a Phoenix operando a «velocidad equivalente a la humana», pero no especifican qué humano ni bajo qué condiciones. Aunque es más rápido de lo que yo sería, eso es seguro.[ Sanctuary AI ]“Suzume” es una película de animación de Makoto Shinkai, en la que uno de los personajes se convierte en una silla de tres patas: Shintaro Inoue del JSK Lab de la Universidad de Tokio ha conseguido construir una versión robótica de esa misma silla, que es muy impresionante:[ Github ]¡Gracias, Shintaro! El robot humanoide EVE entrena para ayudar en el hogar, como poner la compra en los gabinetes de la cocina.[ 1X ]Este es el RAM: cortacésped autónomo robótico. Se puede dejar caer en cualquier parte del mundo y se despertará con la misión de acortar la hierba alta que lo rodea. Aquí hay un breve clip de cómo funciona en el Presidio en SF.[ Electric Sheep ]Este año, nuestros robots afrontaron el invierno finlandés por primera vez. A medida que la nieve se aclara y los días se alargan, recordamos cómo nuestros robots realizaron miles de entregas a clientes de S Group durante los meses más fríos.[ Starship ]Agility Robotics está haciendo todo lo posible para responder a la (muy común) pregunta de «Está bien, pero ¿qué pueden hacer realmente los robots humanoides?»[ Agility Robotics ]Digit es genial y todo eso, pero Cassie siempre será uno de mis robots favoritos.[ CoRIS ]La adopción de cámaras de campo de visión (FoV) omnidireccionales en robots aéreos mejora enormemente la capacidad de percepción, lo que mejora significativamente las capacidades de la robótica aérea en tareas de inspección, reconstrucción y rescate. Proponemos OmniNxt, una plataforma de robótica aérea de código abierto con percepción omnidireccional.[ OmniNxt ]El marco MAkEable mejora la manipulación móvil en entornos diseñados en torno a humanos al agilizar el proceso de compartir habilidades y experiencias aprendidas entre diferentes robots y contextos. Las pruebas prácticas confirman su eficacia en diversos escenarios, en los que participan diferentes robots, en tareas como la captura de objetos, el uso coordinado de ambas manos en tareas y el intercambio de habilidades entre robots humanoides.[ Paper ]Realizamos pruebas de Ringbot al aire libre en una pista de 400 metros. Con una fuente de energía de 2300 miliamperios-hora y 11,1 voltios, Ringbot logró recorrer aproximadamente 3 kilómetros en 37 minutos. Controlamos su velocidad y dirección objetivo utilizando un controlador de joystick remoto (Steam Deck), y Ringbot experimentó cinco caídas durante esta prueba.[ Paper ]Hay una notable falta de coherencia sobre dónde exactamente Boston Dynamics quiere que pienses que están los ojos de Spot.[ Boston Dynamics ]Al igual que con cada video de cocina, se requiere mucha preparación en segundo plano para que este robot cocine una comida completa, pero demolería por completo esas papas fritas.[ Dino Robotics ]Aquí encontrará todo lo que necesita saber sobre los drones de entrega Wing, excepto cuánto tiempo humano realmente requieren y el costo real de realizar entregas mediante drones, porque no es divertido hablar de esas cosas.[ Wing ]Esta conferencia en memoria de CMU Teruko Yata está a cargo de Jonathan Hurst de Agility Robotics, sobre «Robots centrados en el ser humano y cómo el aprendizaje permite la generalidad». Los humanos siempre han soñado con robots ayudantes. La novedad es que este sueño se está haciendo realidad. Los nuevos avances en IA, basados en hardware y dinámica pasiva, permiten una generalidad enormemente mejorada. Los robots pueden salir de entornos altamente estructurados y centrarse más en el ser humano: operar en espacios humanos, interactuar con personas y realizar algunos flujos de trabajo humanos básicos. Al conectar un modelo de lenguaje grande, Digit puede convertir solicitudes de alto nivel en lenguaje natural en instrucciones complejas de robot, componiendo la biblioteca de habilidades en conjunto, utilizando el contexto humano para lograr un trabajo real en el mundo humano. Todo esto es nuevo y nunca volverá atrás: la IA impulsará una rápida revolución robótica que cambiará la forma en que vivimos.[ CMU ]

Video Friday es tu selección semanal de increíbles videos de robótica, recopilados por tus amigos de IEEE Spectrum Robotics. También publicamos un calendario semanal de los próximos eventos de robótica para los próximos meses. Envíenos sus eventos para su inclusión.RoboCup German Open: 17–21 de abril de 2024, KASSEL, ALEMANIAUVSI XPONENTIAL 2024: 22–25 de abril de 2024, SAN DIEGOEurobot Open 2024: 8–11 de mayo de 2024, LA ROCHE-SUR-YON, FRANCIAICRA 2024 : 13–17 de mayo de 2024, YOKOHAMA, JAPÓNRoboCup 2024: 17–22 de julio de 2024, EINDHOVEN, PAÍSES BAJOS¡Disfruta de los videos de hoy!USC, UPenn, Texas A&M, Oregon State, Georgia Tech, Temple University y NASA Johnson Space Center están enseñando como perros robots para navegar por los cráteres de la luna y otras superficies planetarias desafiantes en una investigación financiada por la NASA.[ USC ]AMBIDEX es un robot revolucionario que es rápido, liviano y capaz de realizar una manipulación similar a la de un humano. Hemos añadido un sensor en la cabeza, el torso y la cintura para ampliar enormemente el rango de movimiento. En comparación con la versión anterior centrada en el brazo, la impresión general y el equilibrio han cambiado por completo.[ Naver Labs ]Todavía necesita mucho trabajo, pero el polinizador de seis brazos, Stickbug, ahora puede navegar y polinizar flores de forma autónoma en un invernadero. Creo que «necesita mucho trabajo» en realidad significa «necesita un par de brazos más».[ Paper ]¡Experimente el futuro de la robótica mientras el robot humanoide de UBTECH se integra con ERNIE de Baidu a través de AppBuilder! Robots testigo [that] comprender el lenguaje y realizar de forma autónoma tareas como doblar ropa y clasificar objetos.[ UBTECH ]Sé que las aletas de este robot son para caminar bajo el agua en lugar de en tierra, pero al verlo moverse, siento que está destinado a evolucionar hacia algo un poco más terrestre.[ Paper ] a través de [ HERO Lab ]Además, si es propietario de un robot aspirador, recuerde limpiarlo de vez en cuando. Aquí se explica cómo hacerlo con un Roomba:[ iRobot ]El vídeo muestra las pruebas de cuenca de olas de un vehículo submarino anfibio no tripulado de hélice cicloidal (Cyclo-UUV) de 43 kg (95 lb) desarrollado en el Laboratorio Avanzado de Vuelo Vertical de la Universidad Texas A&M. El uso de ciclohélices permite una vectorización de empuje de 360 grados para una controlabilidad dinámica más robusta en comparación con los UUV con hélices de tornillo convencionales.[ AVFL ]Sony todavía está actualizando Aibo con nuevas funciones, como la capacidad de escuchar tu terrible música y bailar.[ Aibo ]Operar robots con precisión y a altas velocidades ha sido un objetivo de larga data de la investigación en robótica. Para permitir movimientos dinámicos precisos y seguros, presentamos un brazo robótico impulsado por tendones de cuatro grados de libertad (DoF). Los tendones permiten colocar la actuación en la base para reducir la inercia del robot, lo que demostramos que reduce significativamente las fuerzas máximas de colisión en comparación con los sistemas convencionales impulsados por motor. Emparejar nuestro robot con músculos neumáticos permite generar altas fuerzas y movimientos altamente acelerados, mientras se beneficia de la resistencia al impacto a través de la conformidad pasiva.[ Max Planck Institute ]Los rovers en Marte anteriormente quedaron atrapados en suelos sueltos, y al girar las ruedas los excavaron más profundamente, como un automóvil atrapado en la arena. Para evitar esto, Rosalind Franklin cuenta con un exclusivo modo de locomoción sobre ruedas para superar terrenos difíciles, así como un software de navegación autónomo.[ ESA ]Cassie puede caminar sobre arena, grava y rocas dentro del Robot Playground de la Universidad de Michigan. Vaya, se detuvieron antes de llegar a las rocas divertidas.[ Paper ] a través de [ Michigan Robotics ]Nada mal para 2016, ¿verdad?[ Namiki Lab ]MOMO ha aprendido los movimientos de baile de Bam Yang Gang con su destreza manual. 🙂 Al analizar videos de danza en 2D, extraemos datos detallados del esqueleto de la mano, lo que nos permite recrear los movimientos en 3D usando un modelo de mano. Con esta información, MOMO replica los movimientos de baile con las articulaciones de sus brazos y manos.[ RILAB ] a través de [ KIMLAB ]Este seminario GRASP SFI de UPenn es de Eric Jang de 1X Technologies, sobre «Motores de datos para robots humanoides». La misión de 1X es crear un suministro abundante de trabajo físico a través de androides que trabajan junto a los humanos. Compartiré algunos de los avances que 1X ha realizado hacia la manipulación móvil de uso general. Hemos ampliado la cantidad de tareas que nuestros androides pueden realizar combinando una estrategia de aprendizaje de un extremo a otro con un sistema sin código para agregar nuevas capacidades robóticas. Nuestro equipo de operaciones de Android entrena sus propios modelos con los datos que ellos mismos recopilan, lo que produce un conjunto de datos «de la granja a la mesa» de muy alta calidad que se puede utilizar para aprender comportamientos extremadamente capaces. También compartiré un avance del progreso que hemos estado logrando hacia un “modelo mundial” generalista para robots humanoides.[ UPenn ]Este seminario de Microsoft para futuros líderes en robótica e inteligencia artificial es de Chahat Deep Singh de la Universidad de Maryland, sobre «Percepción mínima: habilitación de la autonomía en robots del tamaño de la palma de la mano». La solución a la autonomía de los robots se encuentra en la intersección de la inteligencia artificial, la visión por computadora y imágenes y robótica, lo que da como resultado robots mínimos. Esta charla explora el desafío de desarrollar un marco de percepción mínima para robots diminutos (menos de 6 pulgadas) utilizados en operaciones de campo, como inspecciones espaciales en espacios confinados y polinización por robots. Además, profundizaremos en el ámbito de la percepción selectiva, la IA incorporada y el futuro de la autonomía del robot en la palma de tu mano.[ UMD ]

Source link

Video Friday es tu selección semanal de increíbles videos de robótica, recopilados por tus amigos de IEEE Spectrum Robotics. También publicamos un calendario semanal de los próximos eventos de robótica para los próximos meses. Envíenos sus eventos para su inclusión.RoboCup German Open: 17–21 de abril de 2024, KASSEL, GERMANYAUVSI XPONENTIAL 2024: 22–25 de abril de 2024, SAN DIEGO, CAEurobot Open 2024: 8–11 de mayo de 2024, LA ROCHE-SUR-YON, FRANCIAICRA 2024: 13–17 de mayo de 2024, YOKOHAMA, JAPÓNRoboCup 2024: 17–22 de julio de 2024, EINDHOVEN, PAÍSES BAJOS¡Disfruta de los vídeos de hoy! Los ingenieros de Columbia construyen Emo, una cara robótica revestida de silicio que establece contacto visual y utiliza dos modelos de IA para anticipar y replicar la sonrisa de una persona antes de que realmente sonría: un avance importante en los robots que predicen con precisión las expresiones faciales humanas, mejoran las interacciones y generan confianza entre humanos y robots.[ Columbia ]Investigadores de la Universidad de Stanford han inventado una forma de aumentar los motores eléctricos para hacerlos mucho más eficientes a la hora de realizar movimientos dinámicos a través de un nuevo tipo de actuador, un dispositivo que utiliza energía para hacer que las cosas se muevan. Su actuador, publicado el 20 de marzo en Science Robotics, utiliza resortes y embragues para realizar una variedad de tareas con una fracción del uso de energía de un motor eléctrico típico.[ Stanford ]Lo siento, pero el mundo no necesita más bateristas.[ Fourier Intelligence ]Siempre es bueno ver a Valakyrie de la NASA realizando investigaciones.[ NASA ]En terrenos desafiantes, la construcción de estructuras como antenas y mástiles de teleféricos a menudo requiere el uso de helicópteros para transportar cargas mediante cuerdas. Desafiando este paradigma, presentamos Geranos: un vehículo aéreo no tripulado (UAV) multirotor especializado diseñado para mejorar el transporte y el ensamblaje aéreos. . Nuestra demostración experimental que imita las instalaciones de mástiles de antenas/teleféricos muestra la capacidad de Gerano para apilar postes (3 kilogramos, 2 metros de largo) con una notable precisión de colocación inferior a 5 centímetros, sin necesidad de intervención manual humana.[ Paper ]Elios 2 de Flyability en noviembre de 2020 ayudó a los investigadores a inspeccionar el reactor 5 en el lugar del desastre nuclear de Chernobyl para determinar si había uranio presente en el área. Hasta entonces, el reactor 5 no había sido investigado desde el desastre de 1986.[ Flyability ]Hasta ahora se han desarrollado varios humanoides musculoesqueléticos. Si bien estos humanoides tienen la ventaja de sus cuerpos flexibles y redundantes que imitan el cuerpo humano, todavía están lejos de ser aplicados a tareas del mundo real. Una de las razones de esto es la dificultad de caminar bípedo en un cuerpo flexible. Por lo tanto, desarrollamos un robot musculoesquelético con ruedas, Musashi-W, combinando una base con ruedas y extremidades superiores musculoesqueléticas para aplicaciones del mundo real.[ Paper ]¡Gracias, Kento! Una tendencia reciente en robótica industrial es tener manipuladores robóticos trabajando lado a lado con operadores humanos. Un aspecto desafiante de esta coexistencia es que se requiere que el robot resuelva de manera confiable problemas complejos de planificación de rutas en un entorno que cambia dinámicamente. Para garantizar la seguridad del operador humano y al mismo tiempo lograr la realización eficiente de la tarea, este documento presenta… un esquema [that] puede dirigir el brazo del robot a la postura de efector final deseada en presencia de saturación del actuador, rangos articulares limitados, límites de velocidad, un entorno de obstáculos estáticos desordenado y colaboradores humanos en movimiento.[ Paper ]¡Gracias, Kelly! Nuestro manipulador móvil Digit trabajó de forma continua durante 26 horas divididas en los 3,5 días de Modex 2024, en Atlanta. Todo fue rastreado y coordinado por nuestro producto más nuevo, Agility Arc, una plataforma de automatización en la nube.[ Agility ]Estamos construyendo robots que pueden mantener a las personas fuera de peligro: Spot permite a los operadores investigar y reducir situaciones peligrosas de forma remota. Los robots se han utilizado en aplicaciones gubernamentales y de seguridad pública durante décadas, pero la movilidad inigualable y la interfaz intuitiva de Spot están cambiando la respuesta a incidentes de los departamentos en el campo hoy en día.[ Boston Dynamics ]Este artículo presenta un robot transformador aéreo biestable (BAT), un novedoso vehículo aéreo híbrido (HAV) transformable que cambia entre los modos cuadrotor y ala fija mediante una rápida aceleración y sin ninguna actuación adicional más allá de las necesarias para el vuelo normal.[ Paper ]Baymax de Disney suele ser el centro de atención en muchas presentaciones de investigación dedicadas a la interacción física humano-robot (pHRI) suave y segura. El reciente artículo de KIMLAB en TRO muestra un paso hacia la realización del concepto Baymax al envolver los esqueletos de PAPRAS (Sistema de brazo robótico Plug And Play) con pieles suaves y utilizarlas para funciones sensoriales.[ Paper ]Atrápame si puedes![ CVUT ]El aprendizaje por refuerzo profundo (RL) ha demostrado resultados impresionantes en la resolución de tareas robóticas complejas, como la locomoción cuadrúpeda. Sin embargo, los solucionadores actuales no logran producir políticas eficientes que respeten restricciones estrictas. En este trabajo, abogamos por la integración de restricciones en el aprendizaje de robots y presentamos Restricciones como terminaciones (CaT), un novedoso algoritmo de RL restringido.[ CaT ]¿Por qué el sueño de tener un robot en casa que haga tus tareas aún no se ha hecho realidad? Con tres décadas de experiencia en investigación en este campo, el robótico Ken Goldberg arroja luz sobre la cruda verdad sobre los robots y lo que se necesitará para construir máquinas más diestras para trabajar en un almacén o ayudar en casa.[ TED ]Diseñado como una demostración de tecnología que permitiría realizar hasta cinco vuelos de prueba experimentales en un lapso de 30 días, el helicóptero de Marte superó las expectativas (repetidamente) y recientemente completó su misión después de haber registrado la increíble cantidad de 72 vuelos durante casi tres años. Únase a nosotros para una charla en vivo para aprender cómo el equipo de Ingenuity utilizó el ingenio y la creatividad para transformar el helicóptero de una demostración tecnológica exitosa en un útil explorador para el rover Perseverance, demostrando en última instancia el valor de la exploración aérea para futuras misiones interplanetarias.[ JPL ]Únase a nosotros para una animada mesa redonda con los miembros de la facultad GRASP, el Dr. Pratik Chaudhari, el Dr. Dinesh Jayaraman y el Dr. Michael Posa. Este panel será moderado por el Dr. Kostas Daniilidis en torno al tema candente actual de la IA incorporada en la robótica.[ Penn Engineering ]

Source link

En NVIDIA GTC la semana pasada, el CTO de Boston Dynamics, Aaron Saunders, dio una charla sobre la implementación de IA en robots del mundo real, es decir, cómo Spot está aprovechando el aprendizaje por refuerzo para mejorar la locomoción (hablamos con Saunders el año pasado sobre las caídas de los robots). Y Spot ha mejorado mucho: un robot Spot da una caída en promedio una vez cada 50 kilómetros, incluso cuando la flota de Spot camina colectivamente lo suficiente como para dar la vuelta a la Tierra cada tres meses. Esa flota consta de muchos despliegues comerciales, lo cual es impresionante. para cualquier robot móvil, pero parte de la razón es que la versión actual de Spot en realidad no está destinada a la investigación en robótica, a pesar de que más de 100 universidades albergan al menos un Spot. Boston Dynamics no ha proporcionado a los desarrolladores acceso a las articulaciones de Spot, lo que significa que cualquiera que haya querido explorar la movilidad cuadrúpeda ha tenido que encontrar otra plataforma que sea un poco más abierta y permita cierta experimentación. Boston Dynamics ahora anuncia una nueva variante de Spot que Incluye una interfaz de programación de aplicaciones (API) de bajo nivel que brinda control a nivel conjunto del robot. Esto le dará control (casi) total sobre cómo Spot mueve sus piernas, lo cual es una gran oportunidad para la comunidad de robótica, ya que ahora podremos descubrir exactamente de qué es capaz Spot. Por ejemplo, ya hemos escuchado De una fuente creíble, Spot es capaz de funcionar mucho, mucho más rápido de lo que Boston Dynamics ha demostrado públicamente, y es seguro asumir que un Spot más rápido es solo el comienzo. Un ejemplo de una nueva capacidad de Spot cuando se puede usar un controlador de locomoción personalizado. en el robot.Boston DynamicsCuando compras un robot Spot de Boston Dynamics, llega sabiendo caminar. Es muy, muy bueno para caminar. Boston Dynamics confía tanto en la capacidad de caminar de Spot que solo se le permite un control de alto nivel del robot: usted le dice adónde ir y él decide cómo llegar. Si desea realizar investigaciones sobre robótica utilizando Spot como plataforma de movilidad, está totalmente bien, pero si desea realizar investigaciones sobre locomoción cuadrúpeda, no ha sido posible con Spot. Pero eso está cambiando. El Spot RL Researcher Kit es una colaboración entre Boston Dynamics, Nvidia y el AI Institute. Incluye una API de control de nivel conjunto, una carga útil Nvidia Jetson AGX Orin y un entorno de simulación para Spot basado en Nvidia Isaac Lab. El kit se lanzará oficialmente a finales de este año, pero Boston Dynamics está comenzando una implementación lenta a través de un programa beta de adopción temprana. Desde cierta perspectiva, Boston Dynamics hizo todo esto con Spot al revés: primero creó un producto comercial y solo luego lo hizo. en una plataforma de investigación. «Al principio, sentimos que sería fantástico incluir esa capacidad de investigación, pero que no iba a impulsar la adopción de esta tecnología», nos dijo Saunders después de su sesión del GTC. En cambio, Boston Dynamics se centró primero en llevar muchos Spots al mundo de una manera útil, y solo ahora, cuando la compañía siente que han llegado allí, es el momento adecuado para lanzar una versión de investigación de Spot con todas las funciones. “En realidad, fue simplemente sentirnos cómodos con nuestro producto actual lo que nos permitió regresar y decir: ‘¿Cómo podemos brindarles a las personas el tipo de acceso que anhelan?’”. Llegar a este punto ha requerido un esfuerzo enorme. de trabajo para Boston Dynamics. Como era de esperar, Spot comenzó como una novedad para la mayoría de los primeros usuarios, convirtiéndose en un proyecto para diferentes tipos de grupos de innovación dentro de las empresas en lugar de un activo industrial. «Creo que ha habido un cambio allí», dice Saunders. «Trabajamos mucho más con clientes operativos y la compostura de nuestras ventas está dejando de estar dominadas por los primeros usuarios y estamos empezando a ver ventas repetidas e interés en flotas más grandes de robots». La flota de Spots es una de las cosas que permitió a Boston Dynamics sentirse cómodo ofreciendo una versión de investigación. Los investigadores no son particularmente amigables con sus robots, porque el objetivo de la investigación a menudo es ir más allá de lo que es posible. Y parte de ese proceso incluye familiarizarse con lo que resulta imposible, lo que resulta en robots que terminan en el suelo, a veces en pedazos. La versión de investigación de Spot incluirá un plan de servicio Spot Care obligatorio, que existe para atender a los clientes comerciales, pero que casi con seguridad proporcionará más valor a la comunidad de investigación que quiere ver qué tipo de locuras pueden hacer que Spot haga. ¡Exactamente qué locura! Esas locuras estarán aún por verse. Boston Dynamics está comenzando con un programa beta para los Spots de investigación en parte porque aún no están muy seguros de cuántas salvaguardas implementar dentro de la API. «Necesitamos ver dónde están los problemas», dice Saunders. «Todavía tenemos un poco de trabajo por hacer para perfeccionar realmente cómo lo van a utilizar nuestros clientes». Decidir cuánto debería arriesgarse Spot en nombre de la investigación puede ser una pregunta difícil de responder, pero estoy bastante seguro de que los participantes del programa beta harán todo lo posible para averiguar cuánta tolerancia tiene Boston Dynamics. tiene para Spot travesuras. Solo espero que, pase lo que pase, compartan tantos videos como sea posible. El programa Spot Early Adopter para el nuevo kit de investigación de RL está abierto para solicitudes aquí. Artículos de su sitio Artículos relacionados en la Web

Source link

Video Friday es tu selección semanal de increíbles videos de robótica, recopilados por tus amigos de IEEE Spectrum Robotics. También publicamos un calendario semanal de los próximos eventos de robótica para los próximos meses. Envíenos sus eventos para su inclusión.Eurobot Open 2024: 8–11 de mayo de 2024, LA ROCHE-SUR-YON, FRANCIAICRA 2024: 13–17 de mayo de 2024, YOKOHAMA, JAPÓNRoboCup 2024: 17–22 de julio de 2024, EINDHOVEN, PAÍSES BAJOSDisfrute de los videos de hoy !Vea el viaje de NVIDIA desde ser pionero en hardware avanzado para vehículos autónomos y herramientas de simulación hasta percepción y manipulación aceleradas para robots móviles autónomos y brazos industriales, culminando en la próxima ola de IA de vanguardia para robots humanoides.[ NVIDIA ]En la versión 4.0, mejoramos las habilidades de locomoción de Spot gracias al poder del aprendizaje por refuerzo. Paul Domanico, ingeniero en robótica de Boston Dynamics, habla de cómo el enfoque híbrido de Spot de combinar el aprendizaje por refuerzo con el control predictivo del modelo crea un robot aún más estable en los entornos más antagónicos.[ Boston Dynamics ]Estamos entusiasmados de compartir nuestro último progreso en la enseñanza de habilidades de propósito general a los EVE. Todo en el video es autónomo, todo a velocidad 1X, todo controlado con un único conjunto de pesos de red neuronal.[ 1X ]Lo que encuentro interesante acerca de que el Unitree H1 haga un giro de pie es dónde decide poner sus piernas.[ Unitree ]En la Exposición MODEX de marzo de 2024, Pickle Robot demostró cómo recoger carga de una pila aleatoria similar a lo que se ve en un remolque de camión desordenado después de haber rebotado durante muchos kilómetros de carretera. Las pilas de cajas nunca volvieron a ser las mismas y la manifestación se realizó en vivo frente a una multitud de espectadores 25 veces durante 4 días. Ningún otro sistema robótico de descarga de contenedores o remolques ha demostrado todavía esta capacidad de recoger pilas no estructuradas.[ Pickle ]RunRu es un robot parecido a un coche, un coche parecido a un robot, con autonomía, sociabilidad y operatividad. Se trata de un nuevo tipo de vehículo personal que pretende crear una relación “Jinba-Ittai” con sus pasajeros, que no sólo son siempre asertivos, sino que a veces también se quejan.[ ICD-LAB ]Verdie fue al GTC este año y se ganó el corazón de la gente, pero tal vez no el de los otros robots.[ Electric Sheep ]“DEEPRobotics AI+” combina capacidades de IA con sistemas de software robóticos para impulsar continuamente la inteligencia incorporada. El logro mostrado es el resultado del entrenamiento de un nuevo sistema de software e inteligencia artificial.[ DEEP Robotics ]Si desea recopilar datos para el agarre del robot, usar Stretch y un par de pinzas es lo más asequible posible.[ Hello Robot ]La verdadera razón por la que las piernas de Digit miran hacia atrás es para que no se golpee las espinillas al sacar las GPU del horno. Mientras tanto, algunos de nosotros podemos hornear nuestras GPU sin siquiera necesitar un horno.[ Agility ]P1 es el innovador robot bípedo de pie puntiagudo de LimX Dynamics, que sirve como una plataforma importante para el desarrollo sistemático y las pruebas modulares del aprendizaje por refuerzo. Se utiliza para avanzar en la investigación y la iteración de las habilidades básicas de locomoción bípeda. El éxito de P1 en la conquista del terreno forestal es un testimonio de la investigación y el desarrollo sistemático de LimX Dynamics en el aprendizaje por refuerzo.[ LimX ]Y ahora, esto.[ Suzumori Endo Lab ]Cocinar en las cocinas es divertido. ¡PERO hacerlo en colaboración con dos robots es aún más satisfactorio! Presentamos MOSAIC, un marco modular que coordina múltiples robots para colaborar estrechamente y cocinar con los humanos a través de la interacción del lenguaje natural y un depósito de habilidades.[ Cornell ]neoDavid es un humanoide robusto con diestras habilidades de manipulación, desarrollado en DLR. El objetivo principal en el desarrollo de neoDavid es acercarse lo más posible a las capacidades humanas, especialmente en términos de dinámica, destreza y robustez.[ DLR ]Bienvenido a nuestra serie de videos destacados para clientes donde mostramos algunos de los robots notables en los que nuestros clientes han estado trabajando. En este episodio, mostramos tres UGV de Clearpath Robotics que nuestros clientes utilizan para crear asistentes robóticos para tres aplicaciones diferentes.[ Clearpath ]Este vídeo presenta la nueva mano robótica de tres dedos de KIMLAB, que cuenta con sensores táctiles suaves para mejorar las capacidades de agarre. Aprovechando materiales de impresión 3D rentables, garantiza robustez y eficiencia operativa.[ KIMLAB ]Varios enfoques de planificación conscientes de la percepción han intentado mejorar la precisión de la estimación del estado durante las maniobras, mientras que a menudo se ha pasado por alto la compatibilidad de características entre marcos, un factor crucial que influye en la precisión de la estimación. En este artículo, presentamos APACE, un marco de generación de trayectorias ágil y consciente de la percepción para vuelos agresivos con quadrotores, que tiene en cuenta la compatibilidad de características durante la planificación de trayectorias.[ Paper ] a través de [ HKUST ]En este vídeo, vemos a Samuel Kunz, el piloto del equipo RSL Assistance Robot Race de ETH Zurich, mientras participa en los CYBATHLON Challenges 2024. Samuel completó las cuatro tareas designadas: recuperar un paquete de un buzón, usar un cepillo de dientes, colgar una bufanda en un tendedero y vaciar un lavavajillas, con la ayuda de un robot asistente. Logró una puntuación perfecta de 40 sobre 40 puntos y consiguió el primer puesto en la carrera, completando las tareas en 6,34 minutos.[ CYBATHLON ]Florian Ledoux es un fotógrafo de vida silvestre con un profundo amor por el Ártico y su vida silvestre. Usando el Mavic 3 Pro, pisa el hielo listo para capturar la belleza pura y las historias de este lugar frío y remoto.[ DJI ]

Source link

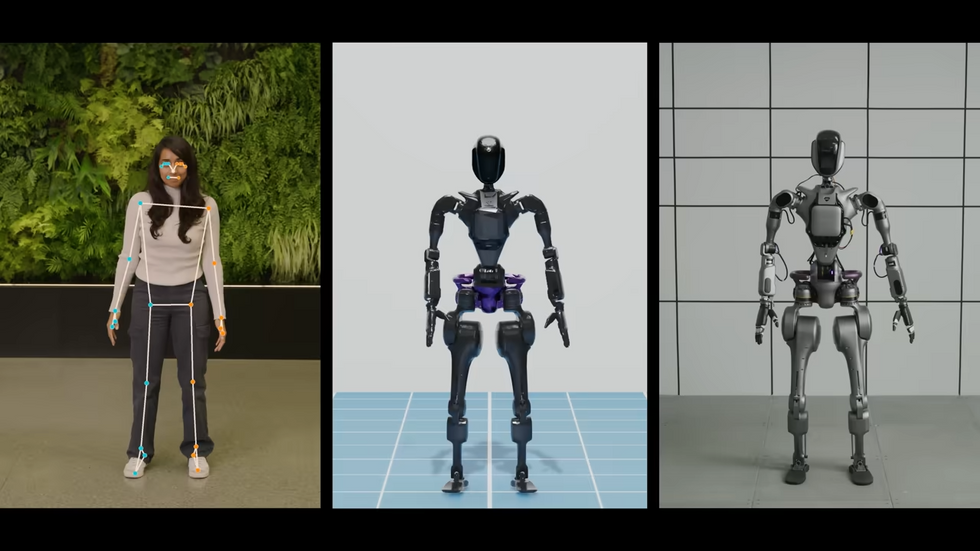

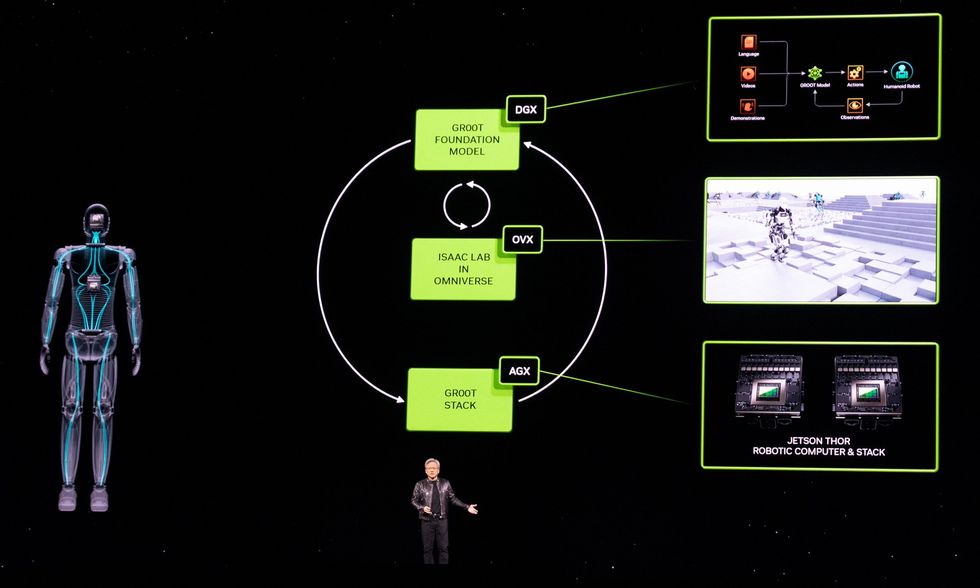

Como era de esperar, la actual conferencia de desarrolladores GTC de Nvidia en San José trata casi exclusivamente sobre IA este año. Pero entre los desarrollos de IA, Nvidia también ha hecho un par de anuncios importantes sobre robótica. Primero, está el Proyecto GR00T (con cada letra y número pronunciados individualmente para no provocar la ira de Disney), un modelo básico para robots humanoides. Y en segundo lugar, Nvidia se ha comprometido a ser el miembro fundador platino de Open Source Robotics Alliance, una nueva iniciativa de la Open Source Robotics Foundation destinada a garantizar que el sistema operativo de robot (ROS), una colección de bibliotecas de software de código abierto y herramientas, tiene el apoyo que necesita para prosperar.GR00TPrimero, hablemos de GR00T (abreviatura de “Tecnología Generalista Robot 00”). La forma en que los presentadores de Nvidia lo enunciaron letra por letra durante sus charlas sugiere claramente que en privado simplemente dicen «Groot». Así que, en lo que a mí respecta, el resto de nosotros también podemos decir simplemente «Groot». Como «modelo básico de propósito general para robots humanoides», el GR00T pretende proporcionar un punto de partida para que robots humanoides específicos realicen tareas específicas. Como es de esperar de algo que se presenta por primera vez en una conferencia magistral de Nvidia, es terriblemente vago en este momento y tendremos que profundizar en ello más adelante. Aquí encontrará prácticamente todo lo útil que Nvidia nos ha contado hasta ahora: “La construcción de modelos básicos para robots humanoides generales es uno de los problemas más interesantes de resolver en la IA hoy en día”, dijo Jensen Huang, fundador y director ejecutivo de NVIDIA. «Las tecnologías habilitadoras se están uniendo para que los principales especialistas en robótica de todo el mundo den pasos de gigante hacia la robótica general artificial». Los robots impulsados por GR00T… serán diseñados para comprender el lenguaje natural y emular movimientos mediante la observación de acciones humanas, aprendiendo rápidamente coordinación y destreza. y otras habilidades para navegar, adaptarse e interactuar con el mundo real. Esto suena bien, pero ese “será” supone mucho trabajo pesado. Aquí falta un “cómo” muy significativo. Más específicamente, necesitaremos una mejor comprensión de lo que subyace a este modelo básico: ¿hay datos reales de robots en alguna parte o se basan en una enorme cantidad de simulación? ¿Las empresas de robótica humanoide implicadas están aportando datos para mejorar GR00T o, por el contrario, entrenando sus propios modelos basándose en ellos? Es ciertamente notable que Nvidia mencione a la mayoría de los pesos pesados en humanoides comerciales, incluidos 1X Technologies, Agility Robotics, Apptronik, Boston Dynamics, Figure AI, Fourier Intelligence, Sanctuary AI, Unitree Robotics y XPENG Robotics. Podremos comunicarnos con algunas de esas personas directamente esta semana para, con suerte, obtener más información. En cuanto al hardware, Nvidia también anuncia una nueva plataforma informática llamada Jetson Thor:Jetson Thor fue creado como una nueva plataforma informática capaz de realizar tareas complejas e interactuar de forma segura y natural con personas y máquinas. Tiene una arquitectura modular optimizada en cuanto a rendimiento, potencia y tamaño. El SoC incluye una GPU de próxima generación basada en la arquitectura NVIDIA Blackwell con un motor transformador que ofrece 800 teraflops de rendimiento de IA de punto flotante de 8 bits para ejecutar modelos de IA generativa multimodal como GR00T. Con un procesador de seguridad funcional integrado, un grupo de CPU de alto rendimiento y 100 GB de ancho de banda Ethernet, simplifica significativamente los esfuerzos de diseño e integración. Hablando de la arquitectura Blackwell de Nvidia, hoy la compañía también presentó su GPU B200 Blackwell. Y para completar los anuncios, la fundición de chips TSMC y Synopsys, una empresa de automatización de diseño electrónico, dijeron que pondrán en producción la herramienta de litografía inversa de Nvidia, cuLitho. La Open Source Robotics AllianceEl otro gran anuncio es en realidad de Open Source Robotics Foundation, que está lanzando Open Source Robotics Alliance (OSRA), una “nueva iniciativa para fortalecer la gobernanza de nuestros proyectos de software de robótica de código abierto y garantizar la salud de la comunidad de Robot Operating System (ROS) Suite durante muchos años por venir. .” Nvidia es el miembro platino inaugural de OSRA, pero no está solo: otros miembros platino incluyen Intrinsic y Qualcomm. Otros miembros importantes incluyen Apex, Clearpath Robotics, Ekumen, eProsima, PickNik, Silicon Valley Robotics y Zettascale. [Open Source Robotics Foundation] Había planeado reestructurar sus operaciones ampliando la participación de la comunidad y expandiendo su impacto en el ecosistema ROS más amplio”, explica Vanessa Yamzon Orsi, directora ejecutiva de la Open Source Robotics Foundation. “La venta de [Open Source Robotics Corporation] fue el primer paso hacia esa visión, y el lanzamiento de OSRA es el siguiente gran paso hacia ese cambio”. Tuvimos tiempo para una breve sesión de preguntas y respuestas con Orsi para comprender mejor cómo afectará esto a la comunidad ROS en el futuro. Usted estructuró la OSRA para que tuviera una membresía mixta y un modelo meritocrático como la Fundación Linux. ¿Qué significa eso exactamente? Vanessa Yamzon Orsi: Hemos modelado la OSRA para permitir caminos hacia la participación en sus actividades a través de membresías pagas (para organizaciones y sus representantes) y los miembros de la comunidad que apoyan los proyectos a través de sus aportes. El modelo mixto permite la participación de la forma más adecuada para cada organización o individuo: contribuyendo con financiación como miembro pagador, contribuyendo directamente al desarrollo del proyecto, o ambos. ¿Cuáles son algunos de los beneficios para el ecosistema ROS que podemos esperar a través de OSRA?Orsi : Esperamos que OSRA beneficie los proyectos de OSRF de tres maneras significativas: proporcionando un flujo estable de financiación para cubrir el mantenimiento y el desarrollo del ecosistema ROS. Fomentando una mayor participación de la comunidad en el desarrollo a través de procesos abiertos y el logro de un estatus meritocrático y abierto. Al lograr una mayor participación de la comunidad en la gobernanza y garantizar que todas las partes interesadas tengan voz en la toma de decisiones. ¿Por qué será esto algo bueno para los usuarios de ROS? Orsi: La OSRA garantizará que ROS y el conjunto de proyectos de código abierto bajo la dirección de Open Robotics seguirá recibiendo apoyo y fortaleciéndose en los años venideros. Al proporcionar gobernanza y supervisión organizadas, caminos más claros hacia la participación comunitaria y apoyo financiero, proporcionará estabilidad y estructura a los proyectos y al mismo tiempo permitirá el desarrollo continuo. De los artículos de su sitio Artículos relacionados en la Web

Source link

La legendaria roboticista del MIT Daniela Rus ha publicado un nuevo libro llamado The Heart and the Chip: Our Bright Future with Robots. «Hay una revolución robótica en marcha», dice Rus en la introducción del libro, «una que ya está provocando cambios masivos en nuestra sociedad y en nuestras vidas». Tiene toda la razón, por supuesto, y aunque algunos de nosotros hemos sentido que esto es cierto durante décadas, podría decirse que ahora es más cierto que nunca. Pero los robots son difíciles y complicados, y la forma en que su progreso está entrelazado con el de los humanos que los fabrican y trabajan con ellos significa que estos cambios no se producirán rápida ni fácilmente. La experiencia de Rus le brinda una perspectiva profunda y matizada sobre el pasado y el futuro de la robótica, y podemos compartir un poco de eso con usted aquí. Daniela Rus: ¿Deberían los robóticos considerar suscribir su propio juramento hipocrático? El siguiente extracto pertenece al capítulo 14, titulado “¿Qué podría salir mal?” Lo cual, seamos honestos, es la pregunta correcta que debes hacer (y luego intentar responder de manera concluyente) siempre que estés pensando en enviar un robot al mundo real. En varios puntos de este libro he mencionado al personaje ficticio Tony Stark. , que utiliza la tecnología para transformarse en el superhéroe Iron Man. Para mí, este personaje es una tremenda inspiración, pero a menudo me recuerdo a mí mismo que en la historia comienza su carrera como fabricante de armas y desarrollador de municiones formado en el MIT. En la película Iron Man de 2008, cambia su forma de actuar porque descubre que las armas especializadas de su empresa están siendo utilizadas por terroristas. Recuerde, los robots son herramientas. Intrínsecamente no son ni buenos ni malos; lo que importa es cómo elegimos usarlos. En 2022, los drones aéreos se utilizaron como armas en ambos bandos de guerras devastadoras. Cualquiera puede comprar un dron, pero existen regulaciones para su uso que varían entre los diferentes países y dentro de ellos. En Estados Unidos, la Administración Federal de Aviación exige que todos los drones estén registrados, con algunas excepciones, incluidos los modelos de juguete que pesen menos de 250 gramos. Las reglas también dependen de si el dron se vuela por diversión o por negocios. Independientemente de las regulaciones, cualquiera podría usar un robot volador para infligir daño, del mismo modo que cualquiera puede blandir un martillo para lastimar a alguien en lugar de clavar un clavo en una tabla. Sin embargo, los drones también se están utilizando para entregar suministros médicos críticos en áreas de difícil acceso, rastrear la salud de los bosques y ayudar a científicos como Roger Payne a monitorear y defender a las especies en riesgo. Mi grupo colaboró con la compañía de danza moderna Pilobolus para montar la primera representación teatral con una mezcla de humanos y drones en 2012, con un robot llamado Seraph. Entonces, los drones también pueden ser bailarines. En la profética novela de ciencia ficción de Kim Stanley Robinson, El Ministerio para el Futuro, se despliega un enjambre de vehículos aéreos no tripulados para estrellar un avión de pasajeros. También puedo imaginar que una bandada de estos pájaros mecánicos se utilice de muchas maneras buenas. Al comienzo de su guerra contra Ucrania, Rusia limitó el acceso de sus ciudadanos a noticias e información imparciales con la esperanza de controlar y dar forma a la narrativa en torno al conflicto. La verdadera historia de la invasión fue sofocada, y me pregunté si podríamos haber enviado un enjambre de pantallas de video voladoras capaces de organizarse en un monitor aéreo gigante en medio de las plazas populares de las ciudades de toda Rusia, mostrando imágenes reales de la guerra, no simplemente clips aprobados por el gobierno. O, aún más simple: enjambres de proyectores digitales voladores podrían haber transmitido las imágenes en los costados de los edificios y las paredes para que todos las vieran. Si hubiéramos desplegado suficientes, habrían sido demasiados como para cerrarlos. Puede haber variaciones de Tony Stark pasando por mi universidad o los laboratorios de mis colegas en todo el mundo, y debemos hacer todo lo posible para garantizar que estas Jóvenes talentosos se esfuerzan por tener un impacto positivo en la humanidad. El personaje de Tony Stark está moldeado por sus experiencias y orientado a tener un impacto positivo en el mundo, pero no podemos esperar a que todos nuestros tecnólogos soporten experiencias desgarradoras que cambian sus vidas. Tampoco podemos esperar que todos utilicen estas máquinas inteligentes para siempre una vez que hayan sido desarrolladas y puestas en circulación. Sin embargo, eso no significa que debamos dejar de trabajar en estas tecnologías: los beneficios potenciales son demasiado grandes. Lo que podemos hacer es pensar más en las consecuencias y poner barreras para garantizar beneficios positivos. Mis contemporáneos y yo no necesariamente podemos controlar cómo se usan estas herramientas en el mundo, pero podemos hacer más para influir en las personas que las fabrican. Puede haber variaciones de Tony Stark pasando por mi universidad o los laboratorios de mis colegas en todo el mundo. , y debemos hacer todo lo posible para garantizar que estos jóvenes talentosos se esfuercen por tener un impacto positivo en la humanidad. Es absolutamente necesario que haya diversidad en nuestros laboratorios universitarios y centros de investigación, pero es posible que podamos hacer más para moldear a los jóvenes que estudian con nosotros. Por ejemplo, podríamos exigir un estudio del Proyecto Manhattan y los dilemas morales y éticos asociados con el fenomenal esfuerzo por construir y utilizar la bomba atómica. En este punto, los cursos de ética no son un requisito generalizado para obtener un título avanzado en robótica o inteligencia artificial, pero tal vez deberían serlo. ¿O por qué no exigir a los graduados que presten juramento a una variación del juramento hipocrático adaptada a la robótica y la IA? El juramento proviene de un antiguo texto médico griego, que puede haber sido escrito o no por el filósofo Hipócrates, y ha evolucionado a lo largo de los años. siglos. Fundamentalmente, representa un estándar de ética médica que se espera que cumplan los médicos. La más famosa de ellas es la promesa de no hacer daño o evitar cometer actos ilícitos intencionales. También aplaudo el enfoque del juramento en el compromiso con la comunidad de médicos y la necesidad de mantener el vínculo sagrado entre maestros y alumnos. Cuanto más vinculados permanezcamos como comunidad de robótica, cuanto más fomentemos y mantengamos nuestras relaciones a medida que nuestros estudiantes salen al mundo, más podremos hacer para dirigir la tecnología hacia un futuro positivo. Hoy en día, el juramento hipocrático no es un requisito universal para obtener la certificación de médico, y tampoco veo que funcione de esa manera para los robóticos. Tampoco soy el primer experto en robótica o líder en inteligencia artificial que sugiere esta posibilidad. Pero deberíamos considerar seriamente convertirlo en una práctica estándar. Después del desarrollo de la bomba atómica, cuando el potencial de los científicos para causar daño se hizo repentina y terriblemente evidente, hubo cierta discusión sobre un juramento hipocrático para los investigadores científicos. La idea ha resurgido de vez en cuando y rara vez gana fuerza. Pero la ciencia trata fundamentalmente de la búsqueda del conocimiento; en ese sentido es puro. En robótica e inteligencia artificial, estamos construyendo cosas que tendrán un impacto en el mundo, su gente y otras formas de vida. En este sentido, nuestro campo se acerca algo más a la medicina, ya que los médicos están utilizando su formación para impactar directamente en la vida de las personas. Pedir a los tecnólogos que reciten formalmente una versión del juramento hipocrático podría ser una forma de seguir impulsando nuestro campo en la dirección correcta, y tal vez servir como control sobre las personas a las que luego se les pide que desarrollen robots o inteligencia artificial expresamente para propósitos nefastos. La idea misma de lo que es bueno o malo, en términos de cómo se utiliza un robot, depende de dónde te sientes. Me opongo firmemente a dar autonomía a los robots armados o armados. No podemos ni debemos confiar en la inteligencia de las máquinas para tomar decisiones sobre si infligir daño a una persona o a un grupo de personas por su cuenta. Personalmente, preferiría que los robots nunca se utilizaran para hacer daño a nadie, pero esto ya no es realista. Los robots se utilizan como herramientas de guerra y es nuestra responsabilidad hacer todo lo posible para darle forma a su uso ético. Por lo tanto, no me separo ni me divorcio de la realidad y opero únicamente en algún universo utópico de robots felices y serviciales. De hecho, imparto cursos sobre inteligencia artificial a funcionarios de seguridad nacional y les asesoro sobre las fortalezas, debilidades y capacidades de la tecnología. Veo esto como un deber patriótico y me siento honrado de ayudar a nuestros líderes a comprender las limitaciones, fortalezas y posibilidades de los robots y otros sistemas físicos mejorados por IA: lo que pueden y no pueden hacer, lo que deben y no deben hacer. , y lo que creo que deben hacer. En última instancia, no importa cuánto enseñemos y prediquemos sobre las limitaciones de la tecnología, la ética de la IA o los peligros potenciales de desarrollar herramientas tan poderosas, las personas tomarán sus propias decisiones, ya sea que estén estudiantes recién graduados o altos líderes de seguridad nacional. Lo que espero y enseño es que debemos elegir hacer el bien. A pesar de los esfuerzos de las empresas de extensión de vida, todos tenemos un tiempo limitado en este planeta, lo que el científico Carl Sagan llamó nuestro “punto azul pálido”, y debemos hacer todo lo posible para aprovechar ese tiempo al máximo y tener un impacto positivo. en nuestro hermoso entorno y en las muchas personas y otras especies con las que lo compartimos. Mi búsqueda de décadas para construir robots más inteligentes y capaces no ha hecho más que fortalecer mi aprecio por (no, maravillarme) las maravillosas criaturas que se arrastran, caminan, nadan, corren, se deslizan y vuelan a través y alrededor de nuestro planeta, y las fantásticas plantas. , también. No deberíamos ocuparnos del trabajo de desarrollar robots que puedan eliminar estas creaciones cósmicamente raras. En cambio, deberíamos centrarnos en desarrollar tecnologías para preservarlos e incluso ayudarlos a prosperar. Esto se aplica a todas las entidades vivientes, incluida la especie que está especialmente preocupada por el surgimiento de las máquinas inteligentes. Extraído de “El corazón y el chip: nuestro brillante futuro con los robots”. Copyright 2024 de Daniela Rus, Gregory Mone. Utilizado con permiso del editor, WW Norton & Company. Reservados todos los derechos.

Source link

Una demostración reciente realizada por la startup de robótica Figure muestra el potencial de la tecnología ChatGPT de OpenAI para impulsar conversaciones similares a las humanas para robots humanoides. Este desarrollo nos acerca a un futuro en el que los robots puedan integrarse perfectamente en nuestras vidas a través de la interacción del lenguaje natural. Los robots humanoides se acercan un paso más a la interacción natural con el procesamiento del lenguaje de OpenAI. Figure está construyendo un robot de propósito general, Figura 01, diseñado para automatizar tareas que actualmente se consideran indeseables o inseguras para los humanos. Al asociarse con OpenAI en enero de 2024, su objetivo era mejorar las capacidades del robot en percepción, razonamiento e interacción. El vídeo recién publicado ofrece un vistazo a estos avances. A través de los modelos de lenguaje de OpenAI, la Figura 01 ahora puede interpretar su entorno y entablar una conversación. El vídeo demuestra la capacidad del robot para identificar objetos, comprender comandos generales y responder en consecuencia. Cuando se le presenta una manzana y se le pide comida, la Figura 01 reconoce la manzana como comestible y cumple la solicitud. En particular, el robot explica su razonamiento, destacando su capacidad no sólo de reaccionar sino también de contextualizar sus acciones. La Figura 01 demuestra aún más su comprensión de situaciones más amplias. Recoge la basura cercana con una simple orden e incluso reconoce la necesidad de mover los platos vacíos a una rejilla para secar. Si bien el robot se toma un momento para procesar cada instrucción, su capacidad para captar la intención detrás de los comandos generales significa un paso significativo hacia la interacción intuitiva entre humanos y robots. La fecha oficial de lanzamiento de la Figura 01 sigue sin revelarse. Sin embargo, la colaboración con OpenAI subraya su compromiso de acelerar el despliegue comercial de estos robots. Este desarrollo tiene el potencial de revolucionar varias industrias mediante la introducción de robots que no sólo pueden realizar tareas sino también colaborar eficazmente con trabajadores humanos a través del lenguaje natural. El futuro de los robots humanoides con procesamiento del lenguaje natural El futuro de los robots humanoides con procesamiento del lenguaje natural (PLN) encierra una inmensa promesa para revolucionar la interacción entre humanos y robots. Estas son algunas áreas potenciales de crecimiento: Colaboración mejorada: imagine robots integrándose perfectamente en los lugares de trabajo, comprendiendo instrucciones habladas e incluso ofreciendo sugerencias para mejorar los flujos de trabajo. La PNL puede capacitar a los robots para que se conviertan en socios colaborativos, no sólo en reemplazos, de los trabajadores humanos. Cuidado mejorado: los robots humanoides equipados con PNL podrían brindar compañía y asistencia a personas mayores o con limitaciones físicas. Podrían comprender y responder solicitudes, ofrecer recordatorios e incluso entablar conversaciones para combatir la soledad. Educación y formación avanzadas: los robots impulsados por PNL podrían personalizar las experiencias de aprendizaje adaptando su estilo de comunicación a cada estudiante. Podrían responder preguntas, brindar comentarios y actuar como tutores incansables, haciendo que la educación sea más accesible y atractiva. Servicio al cliente de siguiente nivel: las interacciones del servicio al cliente podrían transformarse mediante robots que puedan comprender el lenguaje natural, responder preguntas complejas e incluso navegar por los matices emocionales. Esto agilizaría los procesos, mejoraría la satisfacción del cliente y liberaría a los agentes humanos para tareas más complejas. Accesibilidad universal: la PNL puede cerrar la brecha de comunicación para las personas con discapacidad. Los robots podrían traducir el lenguaje de señas, convertir voz en texto y viceversa, fomentando una mayor inclusión social. Desafíos a abordar: Si bien el futuro es brillante, hay desafíos a considerar: Preocupaciones éticas: a medida que los robots se vuelven más sofisticados, será necesario abordar cuestiones relacionadas con el tratamiento ético y el posible desplazamiento laboral. Noticias de la semana de Gizchina Seguridad y protección: Se deben implementar salvaguardias sólidas para garantizar que los robots funcionen de manera segura, mitigando los riesgos potenciales asociados con la IA avanzada. Sesgo y equidad: los algoritmos de PNL pueden heredar sesgos sociales. Abordar estos sesgos es crucial para garantizar que los robots interactúen con todos de manera justa y sin prejuicios. Revolucionando los lugares de trabajo: la PNL puede marcar el comienzo de una nueva era de colaboración entre humanos y robots. Los robots no se limitarán a realizar tareas; entenderán instrucciones habladas, se adaptarán a situaciones cambiantes e incluso ofrecerán sugerencias para mejorar la eficiencia. Imagine una línea de montaje de una fábrica donde los robots no solo manipulan piezas sino que también se coordinan verbalmente con los trabajadores humanos, ajustando dinámicamente el flujo de trabajo para obtener resultados óptimos. Este enfoque colaborativo podría mejorar significativamente la productividad y la seguridad en diversas industrias. La delicada danza del cuidado: los robots humanoides con PNL tienen el potencial de transformar el cuidado de personas mayores y la vida asistida. Imagine un robot compañero que no sólo pueda comprender las solicitudes de ayuda sino también entablar una conversación, reduciendo los sentimientos de aislamiento y soledad. Sin embargo, surgen consideraciones éticas. ¿Podrán los robots reemplazar realmente la conexión y la empatía humanas, especialmente para aquellos en estados vulnerables? Será crucial lograr el equilibrio adecuado entre la asistencia tecnológica y la auténtica atención humana. La democratización de la educación: los robots impulsados por PNL tienen el potencial de personalizar las experiencias de aprendizaje a gran escala. Un robot tutor equipado con PNL podría adaptar sus explicaciones y estilo de comunicación a las necesidades de cada estudiante, brindando retroalimentación inmediata y abordando las brechas de aprendizaje en tiempo real. Esto podría revolucionar la educación, haciéndola más accesible y atractiva para estudiantes de todos los orígenes y estilos de aprendizaje. Sin embargo, garantizar la igualdad de acceso a dicha tecnología será vital para evitar mayores disparidades educativas. Más allá del servicio al cliente: la PNL puede elevar las interacciones de servicio al cliente mucho más allá de las respuestas escritas. Los robots que comprendan el lenguaje natural, incluidos el humor, el sarcasmo y la frustración, podrían agilizar los procesos y mejorar la satisfacción del cliente. Imagine a un cliente explicando un problema complejo a un robot, y el robot no sólo comprende el problema sino que también sugiere soluciones de una manera que resulta natural y útil. Esto liberaría a los agentes humanos para tareas más complejas y crearía una experiencia de cliente más positiva. Cerrar la brecha de comunicación: la PNL puede ser una herramienta poderosa para la inclusión. Los robots que traducen el lenguaje de señas, convierten la voz en texto y viceversa, pueden cerrar la brecha de comunicación para las personas con discapacidad. Esta tecnología tiene el potencial de derribar barreras y fomentar una sociedad más inclusiva. Sin embargo, garantizar que estos robots estén disponibles y accesibles para todos sigue siendo un desafío. Desafíos en el horizonte: si bien el futuro es prometedor, es necesario superar importantes obstáculos. Deben considerarse cuidadosamente las consideraciones éticas en torno al desplazamiento de empleos y el potencial de los robots para exacerbar las desigualdades sociales. Las medidas sólidas de seguridad y protección serán cruciales para mitigar los riesgos potenciales asociados con la IA avanzada. Además, abordar los sesgos inherentes a los algoritmos de PNL es esencial para garantizar que los robots interactúen de manera justa y sin prejuicios. El camino por delante: Los robots humanoides con PNL representan una poderosa tecnología próxima. Si abordamos cuidadosamente los desafíos y priorizamos el desarrollo ético, podemos aprovechar esta tecnología para crear un futuro en el que los robots trabajen a nuestro lado, no en nuestra contra. Este futuro tiene el potencial de mejorar nuestras vidas de innumerables maneras, desde revolucionar los lugares de trabajo hasta fomentar una sociedad más inclusiva. La clave está en el desarrollo responsable, asegurando que estos avances beneficien a toda la humanidad. En general, el futuro de los robots humanoides con PNL está lleno de posibilidades. Al afrontar cuidadosamente los desafíos, podemos aprovechar esta tecnología para crear un futuro en el que los robots trabajen junto a nosotros, mejorando nuestras vidas de muchas maneras. El futuro de los robots humanoides con procesamiento del lenguaje natural (PNL) presenta un panorama fascinante repleto de inmenso potencial y obstáculos cruciales que superar. Aquí hay una inmersión más profunda en este campo en evolución: Descargo de responsabilidad: es posible que algunas de las empresas de cuyos productos hablamos nos compensen, pero nuestros artículos y reseñas son siempre nuestras opiniones honestas. Para obtener más detalles, puede consultar nuestras pautas editoriales y conocer cómo utilizamos los enlaces de afiliados.

Cuando IEEE Spectrum escribió por primera vez sobre Covariant en 2020, era una nueva startup de robótica que buscaba aplicar la robótica a la recolección en almacén a escala a través de la magia de una única red neuronal de extremo a extremo. En ese momento, Covariant se centró en este caso de uso de recolección, porque representa una aplicación que podría proporcionar valor inmediato: las empresas de almacén pagan a Covariant por sus robots para seleccionar artículos en sus almacenes. Pero para Covariant, lo emocionante fue que la recolección de artículos en los almacenes ha generado, durante los últimos cuatro años, una enorme cantidad de datos de manipulación del mundo real, y probablemente puedas adivinar a dónde va esto. Hoy, Covariant anuncia RFM-1 , que la compañía describe como un modelo básico de la robótica que otorga a los robots la «capacidad de razonar similar a la humana». Eso es del comunicado de prensa, y aunque no necesariamente interpretaría demasiado sobre «humanidad» o «razón», lo que Covariant está haciendo aquí es bastante bueno. «Modelo de base» significa que RFM-1 se puede entrenar en más datos para hacer más cosas; por el momento, todo se trata de manipulación del almacén porque para eso ha sido entrenado, pero sus capacidades se pueden ampliar al suministrarle más datos. «Nuestro sistema actual ya es lo suficientemente bueno como para realizar una selección y colocación muy rápida y variable», afirma el cofundador de Covariant, Pieter Abbeel. “Pero ahora vamos un poco más allá. Cualquier tarea, cualquier encarnación: esa es la visión a largo plazo. Modelos básicos de robótica que impulsan miles de millones de robots en todo el mundo”. Por lo que parece, el negocio de Covariant de implementar una gran flota de robots de automatización de almacenes fue la forma más rápida para recopilar las decenas de millones de trayectorias (cómo se mueve un robot durante una tarea) que necesitaban para entrenar el RFM de 8 mil millones de parámetros. -1 modelo.Covariante“La única forma de hacer lo que estamos haciendo es implementando robots en el mundo que recopilen una tonelada de datos”, dice Abbeel. «Que es lo que nos permite entrenar un modelo básico de robótica que tiene una capacidad única». Ha habido otros intentos de este tipo de cosas: el proyecto RTX es un ejemplo reciente. Pero mientras RT-X depende de que los laboratorios de investigación compartan los datos que tienen para crear un conjunto de datos que sea lo suficientemente grande como para ser útil, Covariant lo está haciendo solo, gracias a su flota de robots de almacén. «RT-X representa aproximadamente un millón de trayectorias de datos», afirma Abbeel, «pero podemos superarlo porque obtenemos un millón de trayectorias cada pocas semanas». «Al construir un valioso robot de recolección que se implementa en 15 países con docenas de clientes, esencialmente tenemos una máquina de recolección de datos». —Pieter Abbeel, Covariant Puede pensar en la ejecución actual de RFM-1 como un motor de predicción para la manipulación de objetos basada en succión en entornos de almacén. El modelo incorpora imágenes fijas, vídeos, ángulos de las articulaciones, lectura de fuerza, fuerza de la ventosa: todo lo relacionado con el tipo de manipulación robótica que realiza Covariant. Todas estas cosas están interconectadas dentro de RFM-1, lo que significa que puedes poner cualquiera de esas cosas en un extremo de RFM-1, y del otro extremo del modelo saldrá una predicción. Esa predicción puede ser en forma de imagen, video o una serie de comandos para un robot. Lo que es importante entender acerca de todo esto es que RFM-1 no se limita a seleccionar solo cosas que ha visto antes, o solo trabajando en robots con los que tiene experiencia directa. Esto es lo bueno de los modelos básicos: pueden generalizar dentro del dominio de sus datos de entrenamiento, y es así como Covariant ha podido escalar su negocio con tanto éxito como lo ha hecho, al no tener que volver a entrenar para cada nuevo robot de recolección o cada nuevo artículo. . Lo que es contrario a la intuición de estos modelos grandes es que en realidad son mejores para enfrentar situaciones nuevas que los modelos entrenados específicamente para esas situaciones. Por ejemplo, digamos que desea entrenar un modelo para conducir un automóvil en una carretera. La pregunta, dice Abbeel, es si de todos modos valdría la pena dedicar tiempo a entrenar en otros tipos de conducción. La respuesta es sí, porque conducir en carretera a veces no es conducir en carretera. Habrá accidentes o tráfico en horas pico que requerirán que conduzcas de manera diferente. Si también se ha entrenado para conducir en calles de la ciudad, estará entrenando efectivamente en casos extremos en carreteras, lo que será útil en algún momento y mejorará el rendimiento general. Con RFM-1, es la misma idea: entrenar en muchos tipos diferentes de manipulación (diferentes robots, diferentes objetos, etc.) significa que cualquier tipo de manipulación será mucho más capaz. En el contexto de la generalización, Covariant habla de la capacidad de RFM-1 para «comprender» su entorno. Esta puede ser una palabra complicada con la IA, pero lo relevante es fundamentar el significado de «comprender» en lo que RFM-1 es capaz de hacer. Por ejemplo, no necesitas entender física para poder atrapar una pelota de béisbol, solo necesitas tener mucha experiencia atrapando pelotas de béisbol, y ahí es donde está RFM-1. También se podría razonar cómo atrapar una pelota de béisbol sin experiencia pero con conocimientos de física, y RFM-1 no hace esto, razón por la cual dudo en usar la palabra «comprender» en este contexto. Pero esto nos lleva a otro Capacidad interesante de RFM-1: funciona como una herramienta de simulación muy eficaz, aunque limitada. Como motor de predicción que genera vídeo, puedes pedirle que genere cómo se verán los próximos segundos de una secuencia de acción, y te dará un resultado realista y preciso, basado en todos sus datos. La clave aquí es que RFM-1 puede simular eficazmente objetos que son difíciles de simular tradicionalmente, como los disquetes. Abbeel de Covariant explica que el «modelo mundial» en el que RFM-1 basa sus predicciones es efectivamente un motor de física aprendido. «Construir motores de física resulta ser una tarea muy desalentadora para cubrir realmente todo lo posible que puede suceder en el mundo», dice Abbeel. “Una vez que se obtienen escenarios complicados, se vuelve muy inexacto, muy rápidamente, porque la gente tiene que hacer todo tipo de aproximaciones para que el motor de física funcione en una computadora. Simplemente estamos haciendo la versión de datos a gran escala de esto con un modelo mundial, y está mostrando resultados realmente buenos”. Abbeel da un ejemplo de pedirle a un robot que simule (o prediga) lo que sucedería si un cilindro se coloca verticalmente sobre una cinta transportadora. La predicción muestra con precisión que el cilindro cae y rueda cuando la cinta comienza a moverse, no porque el cilindro esté siendo simulado, sino porque RFM-1 ha visto muchas cosas colocadas en muchas cintas transportadoras. «Dentro de cinco años, no es improbable que lo que estamos construyendo aquí sea el único tipo de simulador que alguien utilice». —Pieter Abbeel, Covariant Esto solo funciona si existe el tipo correcto de datos para que RFM-1 se entrene, por lo que, a diferencia de la mayoría de los entornos de simulación, actualmente no se puede generalizar a objetos o situaciones completamente nuevos. Pero Abbeel cree que con suficientes datos será posible una simulación mundial útil. “Dentro de cinco años, no es improbable que lo que estamos construyendo aquí sea el único tipo de simulador que alguien utilice. Es un simulador más capaz que uno construido desde cero con verificación de colisiones y elementos finitos y todo eso. Todas esas cosas son muy difíciles de incorporar en tu motor de física de cualquier forma, sin mencionar el renderizador para hacer que las cosas se vean como en el mundo real; en cierto sentido, estamos tomando un atajo». RFM-1 también incorpora datos lingüísticos para poder comunicarse de manera más efectiva con los humanos. Covariant Para que Covariant expanda las capacidades de RFM-1 hacia esa visión a largo plazo de modelos básicos que impulsen “miles de millones de robots en todo el mundo”, el siguiente paso es para alimentarlo con más datos de una variedad más amplia de robots que realizan una variedad más amplia de tareas. «Básicamente, hemos creado un motor de ingesta de datos», afirma Abbeel. «Si está dispuesto a proporcionarnos datos de un tipo diferente, también los incorporaremos». «Tenemos mucha confianza en que este tipo de modelo podría impulsar todo tipo de robots, tal vez con más datos sobre los tipos de robots y los tipos de situaciones en las que podría usarse». —Pieter Abbeel, Covariant De una forma u otra, ese camino implicará una gran cantidad de datos, y serán datos que Covariant no está recopilando actualmente con su propia flota de robots de manipulación de almacenes. Entonces, si usted es, digamos, una empresa de robótica humanoide, ¿cuál es su incentivo para compartir todos los datos que ha estado recopilando con Covariant? «El argumento es que les ayudaremos a llegar al mundo real», dice el cofundador de Covariant, Peter Chen. “No creo que haya muchas empresas que tengan IA para hacer que sus robots sean verdaderamente autónomos en un entorno de producción. Si quieren una IA que sea robusta y poderosa y que realmente pueda ayudarlos a ingresar al mundo real, realmente somos su mejor opción”. El argumento central de Covariant aquí es que, si bien es ciertamente posible que cada empresa de robótica entrene sus propios modelos individualmente, el rendimiento —Al menos para cualquiera que intente realizar manipulación—no sería tan bueno como usar un modelo que incorpore todos los datos de manipulación que Covariant ya tiene dentro de RFM-1. «Siempre ha sido nuestro plan a largo plazo ser una empresa modelo de base de robótica», dice Chen. «Simplemente no había suficientes datos, computación y algoritmos para llegar a este punto, pero construir una plataforma universal de IA para robots, de eso se ha ocupado Covariant desde el principio». De los artículos de su sitioArtículos relacionados en la Web

Source link